线程运行原理 栈和栈帧

Java Virtual Machine Stacks (Java 虚拟机栈)

我们都知道 JVM 中由堆、栈、方法区所组成,其中栈内存是给谁用的呢?其实就是线程,每个线程启动后,虚拟 机就会为其分配一块栈内存。

每个栈由多个栈帧(Frame)组成,对应着每次方法调用时所占用的内存

每个线程只能有一个活动栈帧,对应着当前正在执行的那个方法

线程的基本操作 停止线程 一般来说线程执行完毕就会结束,无需手动关闭。但是如果我们想关闭一个正在运行的线程,有什么方法呢?可以看一下Thread类中提供了一个stop()方法,调用这个方法,就可以立即将一个线程终止,非常方便

但stop方法为何会被废弃而不推荐使用?stop方法过于暴力,强制把正在执行的方法停止了

大家是否遇到过这样的场景:电力系统需要维修,此时咱们正在写代码,维修人员直接将电源关闭了,代码还没保存的,是不是很崩溃,这种方式就像直接调用线程的stop方法类似。线程正在运行过程中,被强制结束了,可能会导致一些意想不到的后果。可以给大家发送一个通知,告诉大家保存一下手头的工作,将电脑关闭

打断线程 在java中,线程中断是一种重要的线程写作机制,从表面上理解,中断就是让目标线程停止执行的意思,实际上并非完全如此。在上面中,我们已经详细讨论了stop方法停止线程的坏处,jdk中提供了更好的中断线程的方法,就是interrupt()方法,该方法可以打断线程

严格的说,打断并不会使线程立即退出,而是给线程发送一个通知,告知目标线程,有人希望你退出了!至于目标线程接收到通知之后如何处理,则完全由目标线程自己决定

Interrupt说明

interrupt的本质是将线程的打断标记设为true ,并调用线程的三个parker对象(C++实现级别)unpark该线程

基于以上本质,有如下说明:

打断线程不等于中断线程,有以下两种情况:

打断正在运行中的线程并不会影响线程的运行,但如果线程监测到了打断标记为true,可以自行决定后续处理

打断阻塞中的线程会让此线程产生一个InterruptedException异常,结束线程的运行。但如果该异常被线程捕获住,该线程依然可以自行决定后续处理(终止运行,继续运行,做一些善后工作等等)

注意细节:

1.interrupt()方法为什么可以打断sleep,wait,join方法导致的线程阻塞呢?

网络上的原理解析说是这三个方法内部会不断的轮询打断标记状态是否为true,一旦为true则会抛出InterruptedException,结束线程的阻塞状态**(源码是native,未能验证其正确性)**

2.interrupt()方法不能打断由于线程竞争重量级锁Monitor(synchronized)失败而导致线程进入的阻塞状态

3.如果打断的是处于sleep,wait,join方法的线程(阻塞态),系统会重置打断标志位

1 2 3 public void interrupt () public boolean isInterrupted () public static boolean interrupted ()

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 @Slf4j public class One { public static void main (String[] args) throws ExecutionException, InterruptedException { Thread t1 = new Thread (){ @Override public void run () { while (true ){ try { Thread.sleep(10000 ); } catch (InterruptedException e) { e.printStackTrace(); Thread.currentThread().interrupt(); } if (Thread.currentThread().isInterrupted()){ System.out.println(Thread.currentThread().getName()+"优雅的中止" ); break ; } } } }; System.out.println(t1.getState()); t1.start(); Thread.sleep(1000 ); t1.interrupt(); System.out.println(t1.getState()); } }

yield 调用 yield 会让当前线程从 Running 进入 Runnable 就绪状态,具体那个线程获取cpu的执行器还是得看cpu的任务调度器来决定

cpu调度器有可能还把执行给回刚刚让出cpu执行的线程

线程优先级

线程优先级会提示(hint)调度器优先调度该线程,但它仅仅是一个提示,任务调度器可以忽略它

如果 cpu 比较忙,那么优先级高的线程会获得更多的时间片,但 cpu 闲时,优先级几乎没作用

等待线程结束(join) join的作用和原理和wait基本一致,参考后面wait即可,但二者也有细微的差别,后面也有章节给出了详细的分析

1 2 public final void join () throws InterruptedException;public final synchronized void join (long millis) throws InterruptedException;

第1个方法表示无限等待,它会一直阻塞当前线程。直到目标线程执行完毕

第2个方法有个参数,用于指定等待时间,如果超过了给定的时间目标线程还在执行,当前线程也会停止等待,而继续往下执行。如果当目标线程早已运行结束,那么即使线程还没有到等待事件也会停止等待

守护线程 概念:进程会等待所有非守护线程运行结束,进程才会结束。而进程不会等待守护线程运行结束,就要所有非守护运行线程结束,即使守护线程仍未结束,进程也会强行结束

守护线程的作用和应用场景暂时不清晰

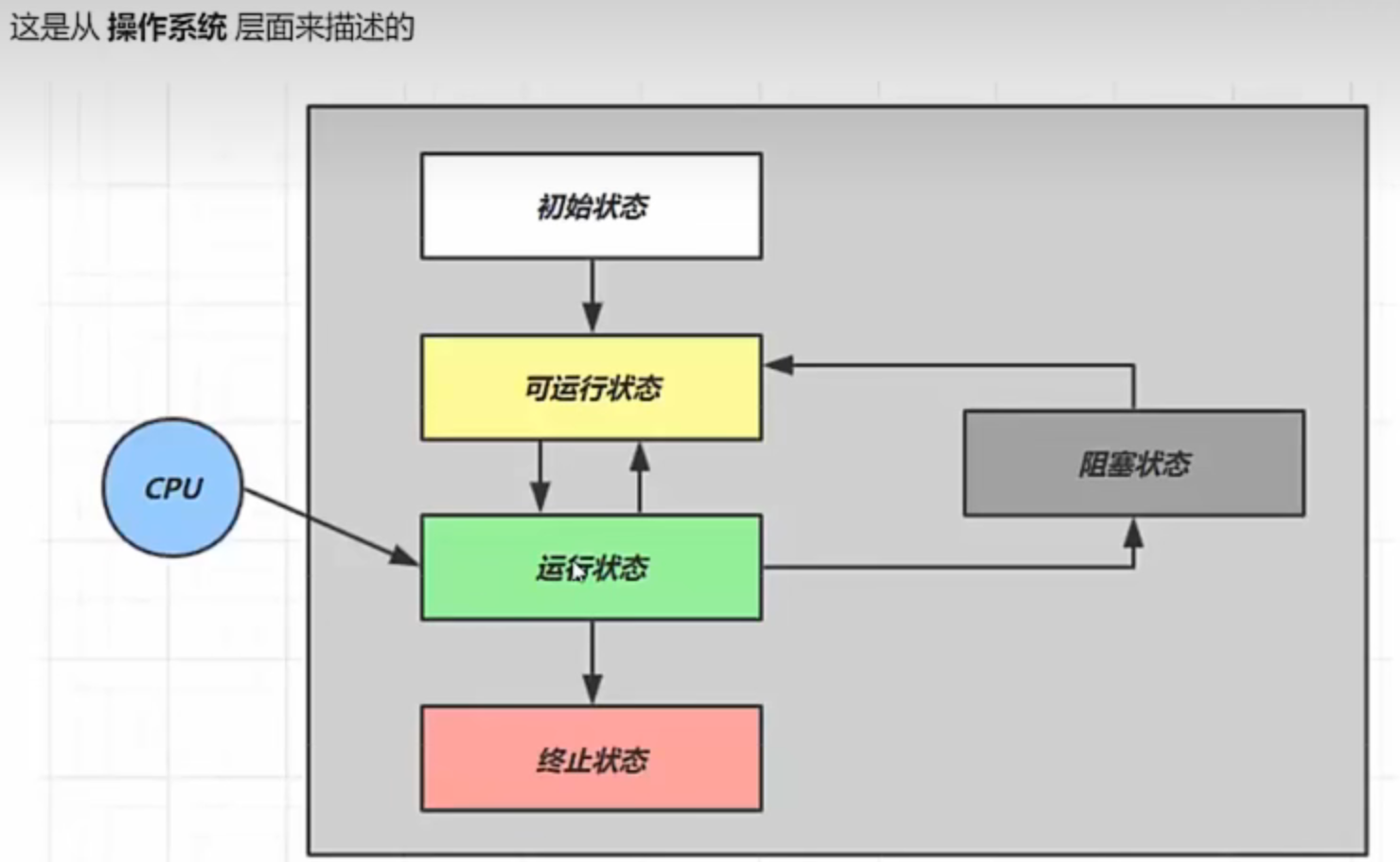

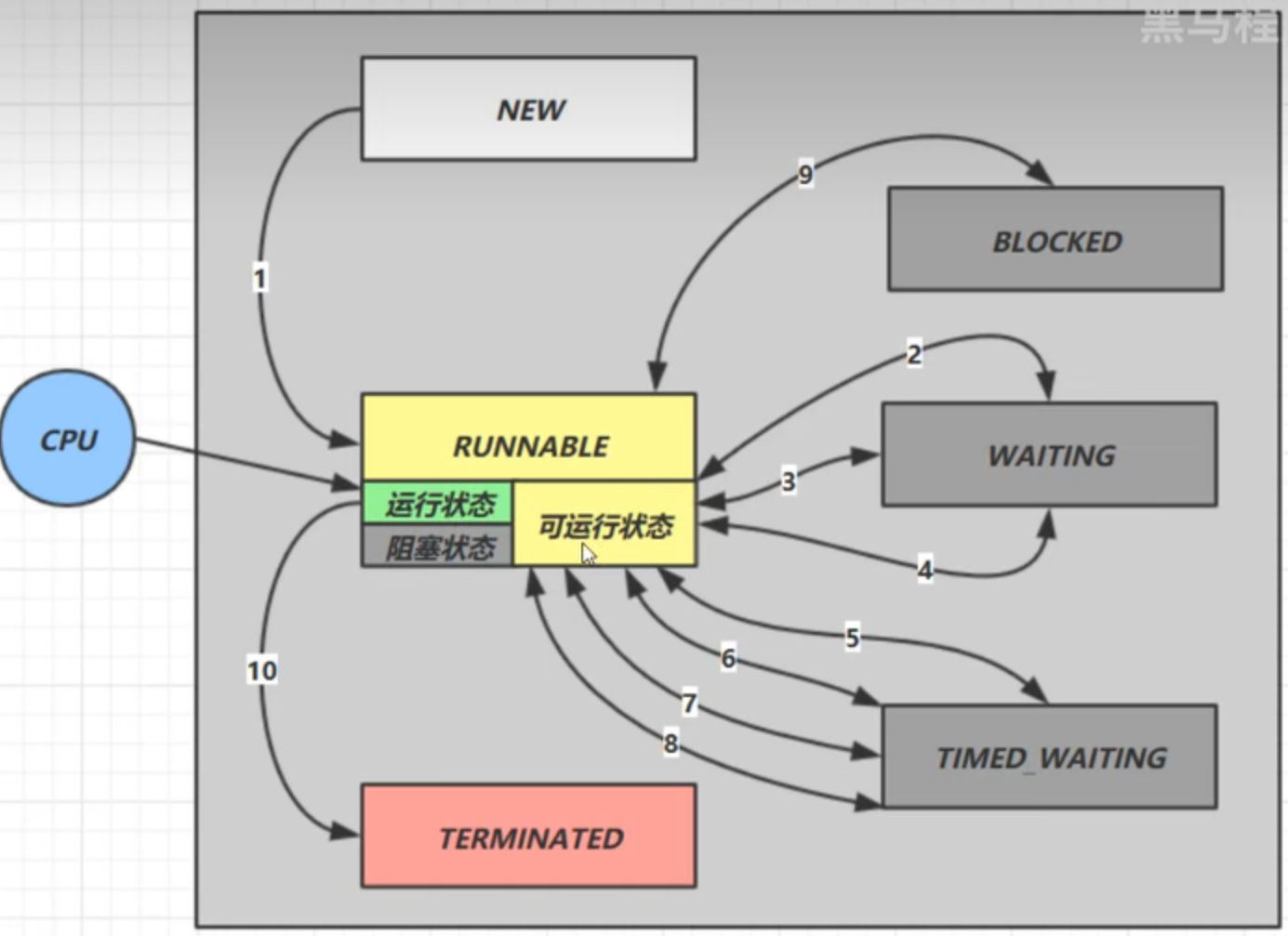

线程的五种状态及其转换 操作系统层面

Java-API层面

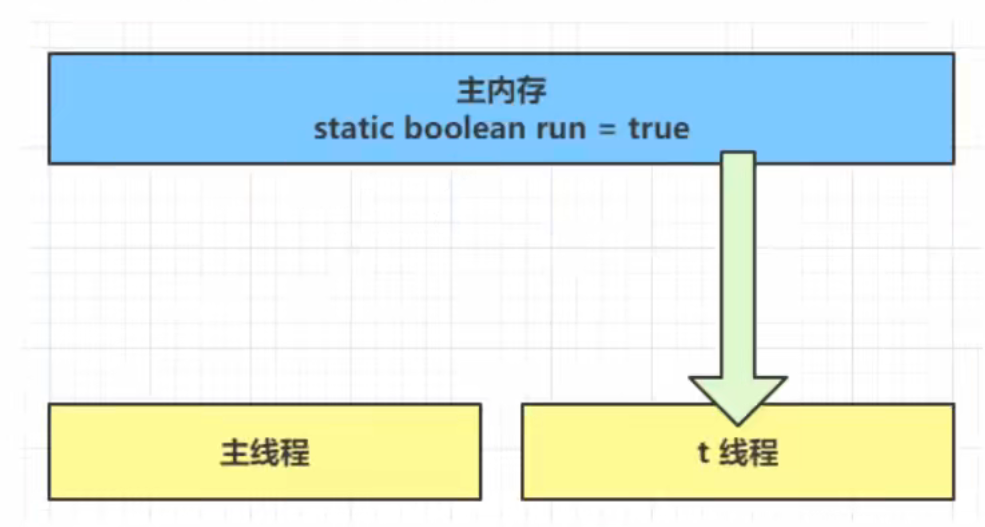

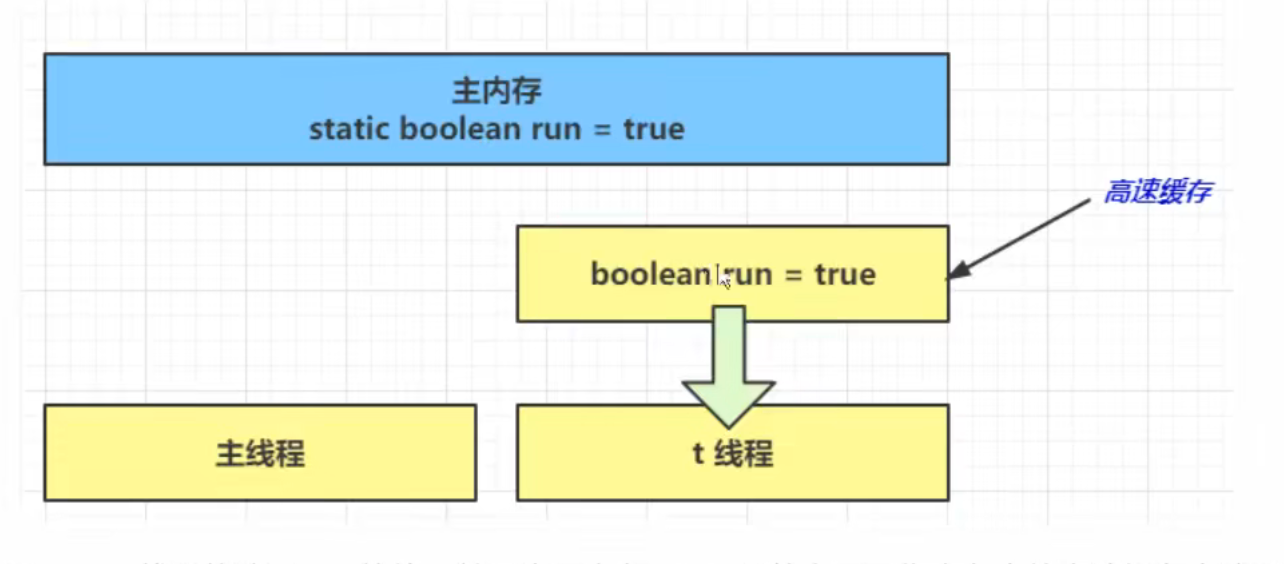

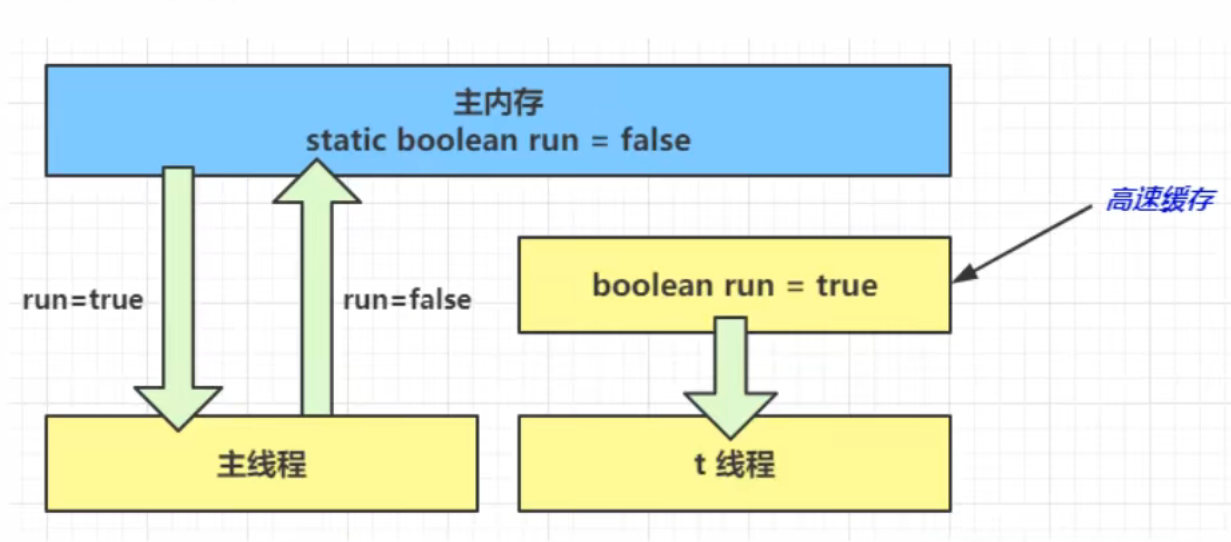

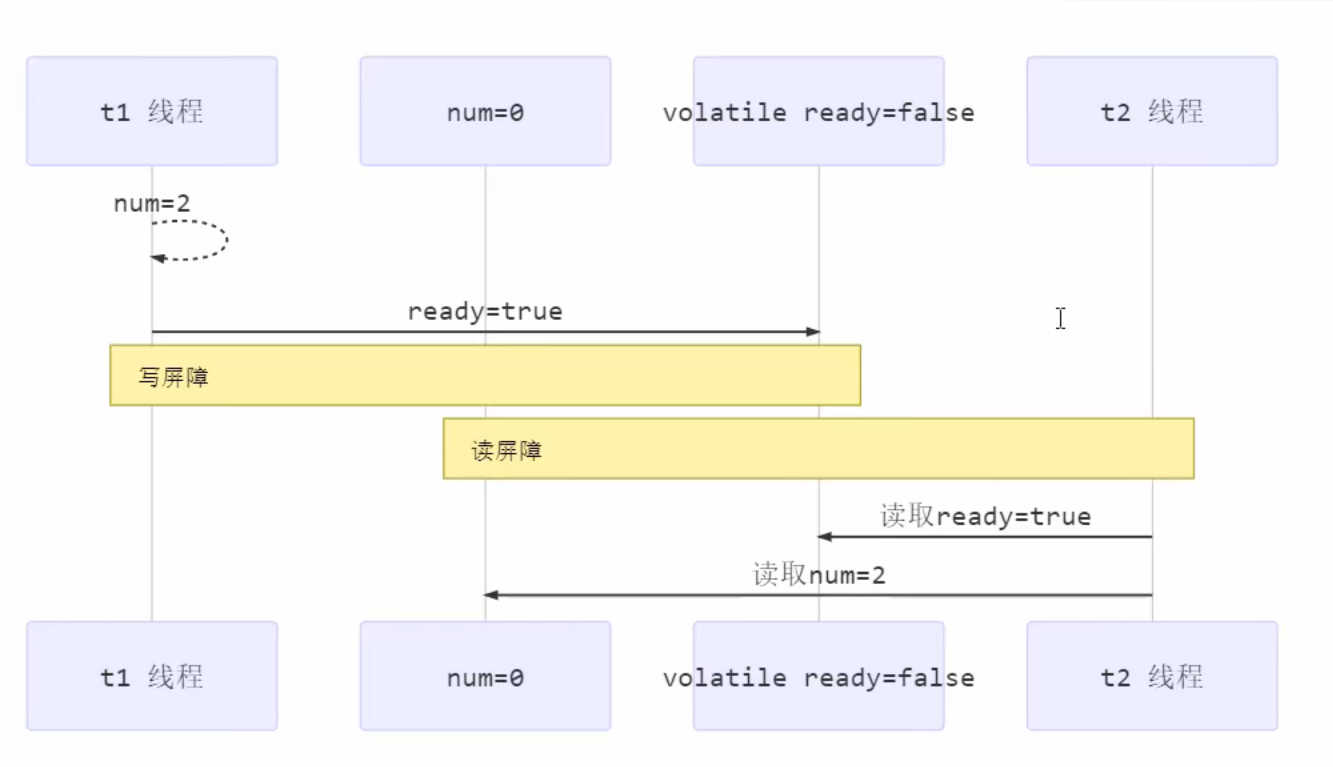

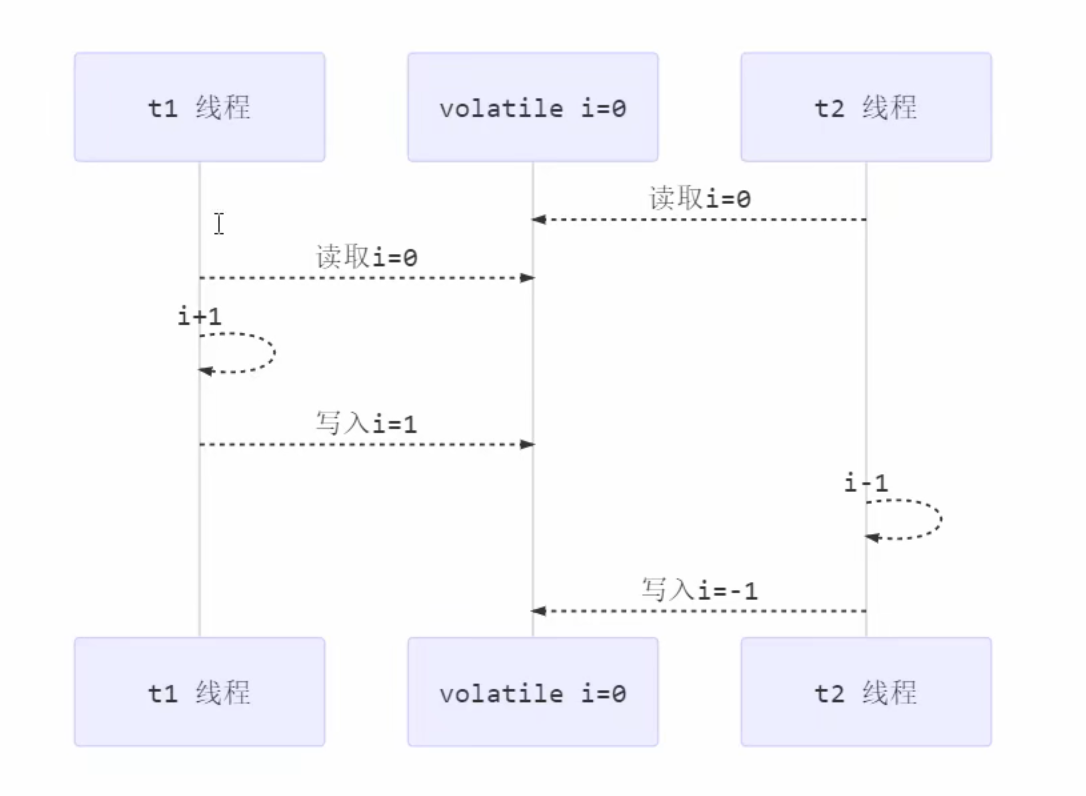

共享模型之管程(Monitor) 多线程操作共享数据带来的问题 线程安全问题产生的前提条件:多个线程同时操作共享数据

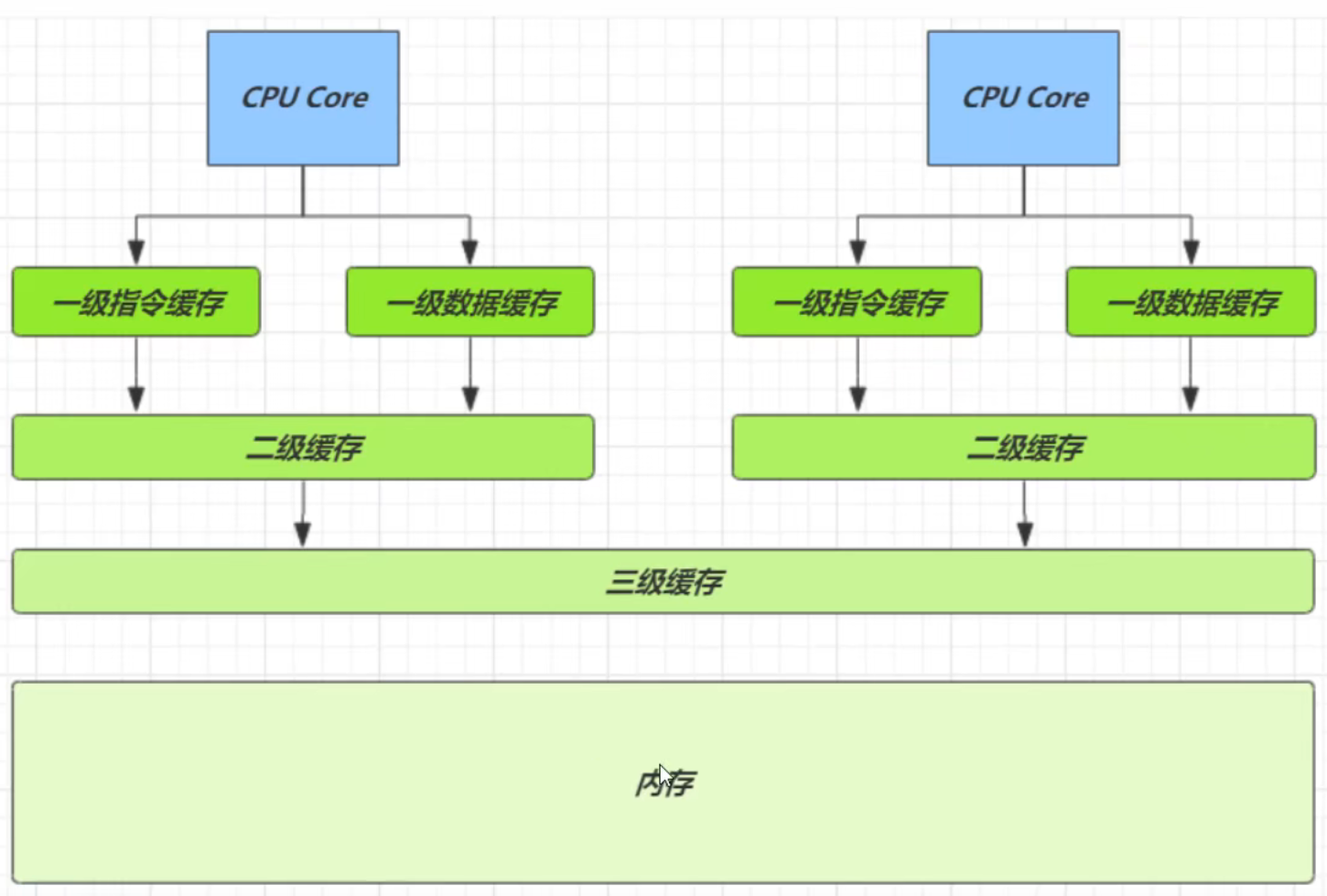

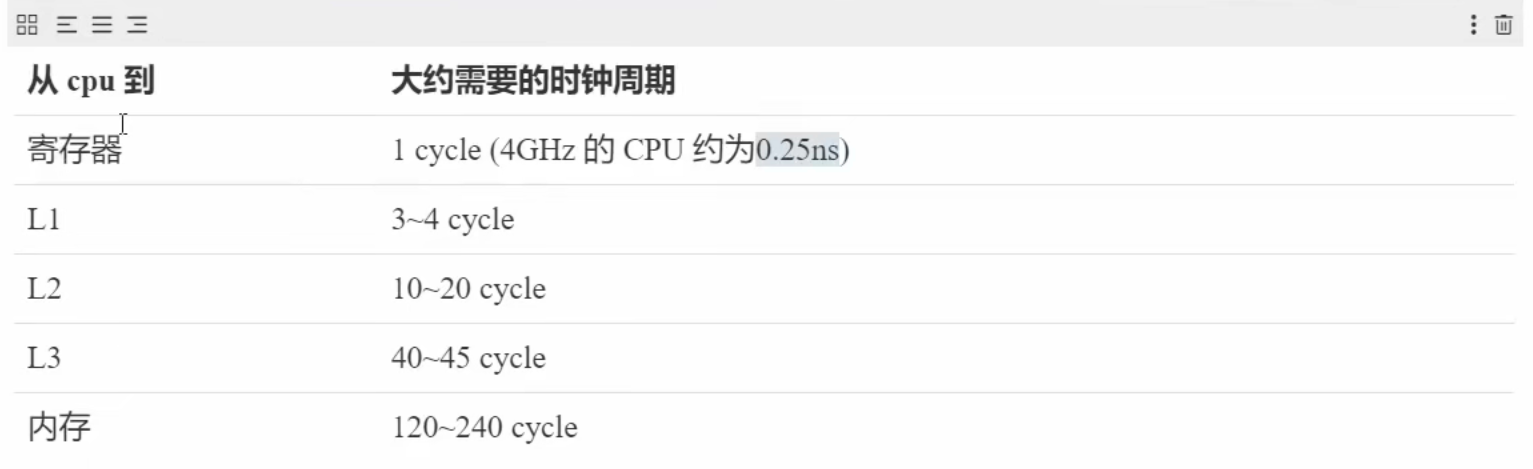

那么产生线程安全问题的核心原因是什么呢?

不能保证对共享数据的操作是原子性(下面有详细的原因分析)

Java代码示例 两个线程对初始值为 0 的静态变量一个做自增,一个做自减,各做 5000 次,结果是 0 吗?

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 static int counter = 0 ;public static void main (String[] args) throws InterruptedException { Thread t1 = new Thread (() -> { for (int i = 0 ; i < 5000 ; i++) { counter++; } }, "t1" ); Thread t2 = new Thread (() -> { for (int i = 0 ; i < 5000 ; i++) { counter--; } }, "t2" ); t1.start(); t2.start(); t1.join(); t2.join(); log.debug("{}" ,counter); }

问题分析&解决方案 以上的结果可能是正数、负数、零。为什么呢?因为 Java 中对静态变量的自增,自减并不是原子操作,要彻底理解,必须从字节码来进行分析

例如对于 i++ 而言(i 为静态变量),实际会产生如下的 JVM 字节码指令:

1 2 3 4 getstatic i iconst_1 iadd putstatic i

而对应 i– 也是类似:

1 2 3 4 getstatic i iconst_1 isub putstatic i

实际上任何操作都有获取值,将处理完的值写入到结果存储器中这两个操作。

而问题产生的核心原因就在于一个线程因为cpu分配的时间片用完了而未能将处理完的值写入到结果中,导致其他获取到cpu执行权的线程对数据的操作都是无效的,因为当cpu再次切换到未执行完的原线程时,会覆盖此前一系列线程对数据的操作结果

例如:当cpu重新将执行权分配给原来尚未执行写入结果操作的线程时,该线程会继续执行,也就是将刚才处理的结果写入到结果存储器中,就会完全覆盖其他线程对该数据的处理结果

对原因更深一步分析:

实质就算线程交叉运行会导致线程互相覆盖彼此对数据的操作结果,进而产生错误的数据。用一个专业术语来描述就是没有保证线程操作的原子性

那么如何保证线程完全将操作执行完(线程操作的原子性)才让其他线程继续操作共享数据呢?

初步解决方案 :能不能让线程将操作完全执行完再发生线程的上下文切换呢?

答案是不能,因为cpu分配的时间片有限,线程的上下文切换是必然会发生的,我们不可能等一个线程将操作完全执行完再发生线程的上下文切换的。

最终解决方案:既然不能避免线程上下文的切换,那就让其他线程在原线程的操作尚未完全执行完全时,拒绝让其他线程访问共享数据,直到原线程的操作完全执行完才允许其他线程访问共享数据,用专业的术语来说就是实现线程的同步 or 互斥效果

那最终解决方案具体怎么实现呢?

通过给操作的代码加锁即可实现

锁的具体作用是什么呢?为什么给操作的代码加锁就可以实现了呢?

锁的作用:要想对共享数据进行操作,必须获取相应的锁资源才能操作

具体实现:

那么在加了锁的情况下就可以保证即使在cpu将执行权分配给了其他线程时,其他线程也操作不了共享数据,因为其他线程要想操作共享数据必须获取相应的锁资源,而此时锁资源一直在原线程手中并没有被释放

也就是其他线程要想操作共享数据必须等原线程释放锁,那么原线程只要保证在操作执行完再释放锁就可以实现操作的原子性了

synchronized实现加锁 在Java层面,典型的两种锁:对象锁和类锁

对象锁:只要是同一个对象,那使用的就是同一把锁

1 2 3 4 5 6 7 8 9 10 11 12 13 class Test { public synchronized void test () { } } class Test { public void test () { synchronized (this ) { } } }

类锁:只要是同一个类,那使用就是同一把锁

1 2 3 4 5 6 7 8 9 10 11 12 class Test { public synchronized static void test () { } } 等价于 class Test { public static void test () { synchronized (Test.class) { } } }

变量的线程安全分析 分析变量是否是线程安全的核心点有两个:

1.变量是否是共享数据

2.是否存在多线程对共享数据的操作

成员变量和静态变量是否线程安全?

如果它们没有共享,则线程安全

如果它们被共享了,根据它们的状态是否能够改变,又分两种情况

如果只有读操作,则线程安全

如果有读写操作,则这段代码是临界区,需要考虑线程安全

局部变量是否线程安全?

局部变量是线程安全的

但局部变量引用的对象则未必

如果该对象没有逃离方法的作用访问,它是线程安全的

如果该对象逃离方法的作用范围,需要考虑线程安全

普通的局部变量因为不是共享数据是不可能存在线程安全问题的

局部引用是因为可能会通过会暴露引用从而导致局部引用成为共享数据

局部变量线程安全分析 1 2 3 4 public static void test1 () { int i = 10 ; i++; }

每个线程调用 test1() 方法时局部变量 i,会在每个线程的栈帧内存中被创建多份,因此不存在共享

局部变量的引用稍有不同

先看一个成员变量的例子

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 class ThreadUnsafe { ArrayList<String> list = new ArrayList <>(); public void method1 (int loopNumber) { for (int i = 0 ; i < loopNumber; i++) { method2(); method3(); } } private void method2 () { list.add("1" ); } private void method3 () { list.remove(0 ); } }

测试类执行方法代码

1 2 3 4 5 6 7 8 9 10 static final int THREAD_NUMBER = 2 ;static final int LOOP_NUMBER = 200 ;public static void main (String[] args) { ThreadUnsafe test = new ThreadUnsafe (); for (int i = 0 ; i < THREAD_NUMBER; i++) { new Thread (() -> { test.method1(LOOP_NUMBER); }, "Thread" + i).start(); } }

因为ArrayList集合是共享数据,并且ArrayList集合的操作并没有对线程安全问题进行处理

具体分析:

因为add不是线程安全的,2个线程同时执行add最后可能只add了一个元素,然后remove2次就报错了

通过观察add方法源码即可理解,添加元素发现线程安全问题的核心是size++,和前面分析的i++原理是一致的

异常分析:两个线程同时添加元素,同时获取size的值,此时一个线程添加完元素尚未执行完索引自增如0+1的操作,而另一个线程却获取到了错误的数据0,那么该线程将会继续对索引0的位置赋值,就会覆盖上一个线程已经添加的元素值。那么实际上只添加了一个元素执行了两次删除操作,自然就发生异常了

1 2 3 4 5 public boolean add (E e) { ensureCapacityInternal(size + 1 ); elementData[size++] = e; return true ; }

解决方案:

将 list 修改为局部变量就不会有上述问题了,因为ArrayList集合不是共享数据了

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 class ThreadSafe { public final void method1 (int loopNumber) { ArrayList<String> list = new ArrayList <>(); for (int i = 0 ; i < loopNumber; i++) { method2(list); method3(list); } } private void method2 (ArrayList<String> list) { list.add("1" ); } private void method3 (ArrayList<String> list) { list.remove(0 ); } }

方法访问修饰符带来的思考,如果把 method2 和 method3 的方法修改为 public 会不会带来线程安全问题?

结论是有可能带来线程安全问题,因为可以通过子类重写父类方法的方式暴露局部引用

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 class ThreadSafe { public final void method1 (int loopNumber) { ArrayList<String> list = new ArrayList <>(); for (int i = 0 ; i < loopNumber; i++) { method2(list); method3(list); } } private void method2 (ArrayList<String> list) { list.add("1" ); } private void method3 (ArrayList<String> list) { list.remove(0 ); } } class ThreadSafeSubClass extends ThreadSafe { @Override public void method3 (ArrayList<String> list) { new Thread (() -> { list.remove(0 ); }).start(); } }

从这个例子可以看出 private 或 final 提供【安全】的意义所在,请体会开闭原则中的【闭】

常见线程安全类

String

Integer

StringBuffer

Random

Vector

Hashtable

java.util.concurrent 包下的类

这里说它们是线程安全的是指,多个线程调用它们同一个实例的某个方法时,是线程安全的。也可以理解为

1 2 3 4 5 6 7 Hashtable table = new Hashtable ();new Thread (()->{ table.put("key" , "value1" ); }).start(); new Thread (()->{ table.put("key" , "value2" ); }).start();

它们的每个方法是原子的

但注意它们多个方法的组合不是原子的,见后面分析

线程安全类方法的组合

分析下面代码是否线程安全?

1 2 3 4 5 Hashtable table = new Hashtable ();if ( table.get("key" ) == null ) { table.put("key" , value); }

非常容易混淆的点:如果每个操作是原子性的,但操作之间的组合并非是原子性的

就拿这个案例来分析:

线程 1:

时间点1:申请获取锁资源成功,调用table.get方法

时间点2:调用完table.get方法后,释放锁资源,再次申请锁资源失败,阻塞等待锁资源的释放

时间点3:仍在继续阻塞等待锁资源的释放

时间点4:申请锁资源成功,调用table.put方法,方法调用完毕

线程2:

时间点1:申请获取锁资源失败(因为线程1获取了锁资源),无法调用table.get方法,阻塞等待锁资源的释放

时间点2:申请获取锁资源成功,调用table.get方法

时间点3:调用完table.get方法后,释放锁资源,但此时再次由线程2比线程1先申请成功获取锁资源

时间点4:执行table.put完方法,执行完释放锁资源

从这个案例可以很清晰的看出,两个线程的操作一直在交叉执行

很明显,虽然每个操作都是原子性的,但每个操作执行完后会释放锁资源,此时另一个线程就可以获取到锁资源并执行相关的操作,所以即使每个操作都是原子性的,但并不能保证操作之间的组合是原子性的

不可变类线程安全性

String、Integer 等都是不可变类,因为其内部的状态不可以改变,因此它们的方法都是线程安全的 有同学或许有疑问,String 有 replace,substring 等方法【可以】改变值啊,那么这些方法又是如何保证线程安全的呢?

不可变类线程安全的核心:因为不可变类中的数据是不能改变的,所以不可能存在对共享数据的写操作,自然就会出现线程安全问题了

1 2 3 4 5 6 7 8 9 public class Immutable { private int value = 0 ; public Immutable (int value) { this .value = value; } public int getValue () { return this .value; } }

如果想增加一个增加的方法呢?

1 2 3 4 5 6 7 8 9 10 11 12 13 public class Immutable { private int value = 0 ; public Immutable (int value) { this .value = value; } public int getValue () { return this .value; } public Immutable add (int v) { return new Immutable (this .value + v); } }

实例分析 例题概括:因为Tomcat中的servlet是单例的,所以Servlet中的成员变量都是共享数据,如果没有对共享数据进行线程安全的处理(操作的原子性),那么都会存在线程安全问题

例1:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 public class MyServlet extends HttpServlet { Map<String,Object> map = new HashMap <>(); String S1 = "..." ; final String S2 = "..." ; Date D1 = new Date (); final Date D2 = new Date (); public void doGet (HttpServletRequest request, HttpServletResponse response) { } }

例2:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 public class MyServlet extends HttpServlet { private UserService userService = new UserServiceImpl (); public void doGet (HttpServletRequest request, HttpServletResponse response) { userService.update(...); } } public class UserServiceImpl implements UserService { private int count = 0 ; public void update () { count++; } }

例3:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 @Aspect @Component public class MyAspect { private long start = 0L ; @Before("execution(* *(..))") public void before () { start = System.nanoTime(); } @After("execution(* *(..))") public void after () { long end = System.nanoTime(); System.out.println("cost time:" + (end-start)); } }

例4:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 public class MyServlet extends HttpServlet { private UserService userService = new UserServiceImpl (); public void doGet (HttpServletRequest request, HttpServletResponse response) { userService.update(...); } } public class UserServiceImpl implements UserService { private UserDao userDao = new UserDaoImpl (); public void update () { userDao.update(); } } public class UserDaoImpl implements UserDao { public void update () { String sql = "update user set password = ? where username = ?" ; try (Connection conn = DriverManager.getConnection("" ,"" ,"" )){ } catch (Exception e) { } } }

例5:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 public class MyServlet extends HttpServlet { private UserService userService = new UserServiceImpl (); public void doGet (HttpServletRequest request, HttpServletResponse response) { userService.update(...); } } public class UserServiceImpl implements UserService { private UserDao userDao = new UserDaoImpl (); public void update () { userDao.update(); } } public class UserDaoImpl implements UserDao { private Connection conn = null ; public void update () throws SQLException { String sql = "update user set password = ? where username = ?" ; conn = DriverManager.getConnection("" ,"" ,"" ); conn.close(); } }

例6:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 public class MyServlet extends HttpServlet { private UserService userService = new UserServiceImpl (); public void doGet (HttpServletRequest request, HttpServletResponse response) { userService.update(...); } } public class UserServiceImpl implements UserService { public void update () { UserDao userDao = new UserDaoImpl (); userDao.update(); } } public class UserDaoImpl implements UserDao { private Connection = null ; public void update () throws SQLException { String sql = "update user set password = ? where username = ?" ; conn = DriverManager.getConnection("" ,"" ,"" ); conn.close(); } }

例7:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 public abstract class Test { public void bar () { SimpleDateFormat sdf = new SimpleDateFormat ("yyyy-MM-dd HH:mm:ss" ); foo(sdf); } public abstract foo (SimpleDateFormat sdf) ; public static void main (String[] args) { new Test ().bar(); } }

其中 foo 的行为是不确定的,存在暴露局部引用的可能

1 2 3 4 5 6 7 8 9 10 11 12 public void foo (SimpleDateFormat sdf) { String dateStr = "1999-10-11 00:00:00" ; for (int i = 0 ; i < 20 ; i++) { new Thread (() -> { try { sdf.parse(dateStr); } catch (ParseException e) { e.printStackTrace(); } }).start(); } }

Monitor 概念 Java 对象头 以 32 位虚拟机为例

普通对象

1 2 3 4 5 |-------------------------------------------------------------- | | Object Header (64 bits) | |------------------------------------ |-------------------------| Mark Word (32 bits) | Klass Word (32 bits) ||------------------------------------ |-------------------------|

数组对象

1 2 3 4 5 |--------------------------------------------------------------------------------- | | Object Header (96 bits) | |-------------------------------- |-----------------------|------------------------ | | Mark Word(32bits) | Klass Word (32bits) | array length(32bits) | |-------------------------------- |-----------------------|------------------------ |

其中 Mark Word 结构 为

1 2 3 4 5 6 7 8 9 10 11 12 13 |------------------------------------------------------- |--------------------| Mark Word (32 bits) | State ||------------------------------------------------------- |--------------------| hashcode: 25 | age:4 | biased_lock: 0 | 01 | Normal |-------------------- ||thread:23 |epoch: 2 | age:4 | biased_lock: 1 | 01 | Biased | -------------------- || ptr_to_lock_record:30 | 00 | Lightweight Locked | |------------------------------------------------------- |--------------------| ptr_to_heavyweight_monitor: 30 | 10 | Heavyweight Locked |-------------------- || | 11 | Marked for GC | |------------------------------------------------------- |--------------------|

64 位虚拟机 Mark Word

1 2 3 4 5 6 7 8 9 10 11 12 13 |-------------------------------------------------------------------- |--------------------| Mark Word (64 bits) | State ||-------------------------------------------------------------------- |--------------------| unused: 25 | hashcode:31 | unused: 1 | age:4 | biased_lock: 0 | 01 | Normal |-------------------- || thread:54 | epoch: 2 | unused:1 | age: 4 | biased_lock:1 | 01 | Biased | |-------------------------------------------------------------------- |--------------------| ptr_to_lock_record: 62 | 00 | Lightweight Locked |-------------------- || ptr_to_heavyweight_monitor:62 | 10 | Heavyweight Locked | |-------------------------------------------------------------------- |--------------------| 11 | Marked for GC |-------------------- |

参考资料

https://stackoverflow.com/questions/26357186/what-is-in-java-object-header

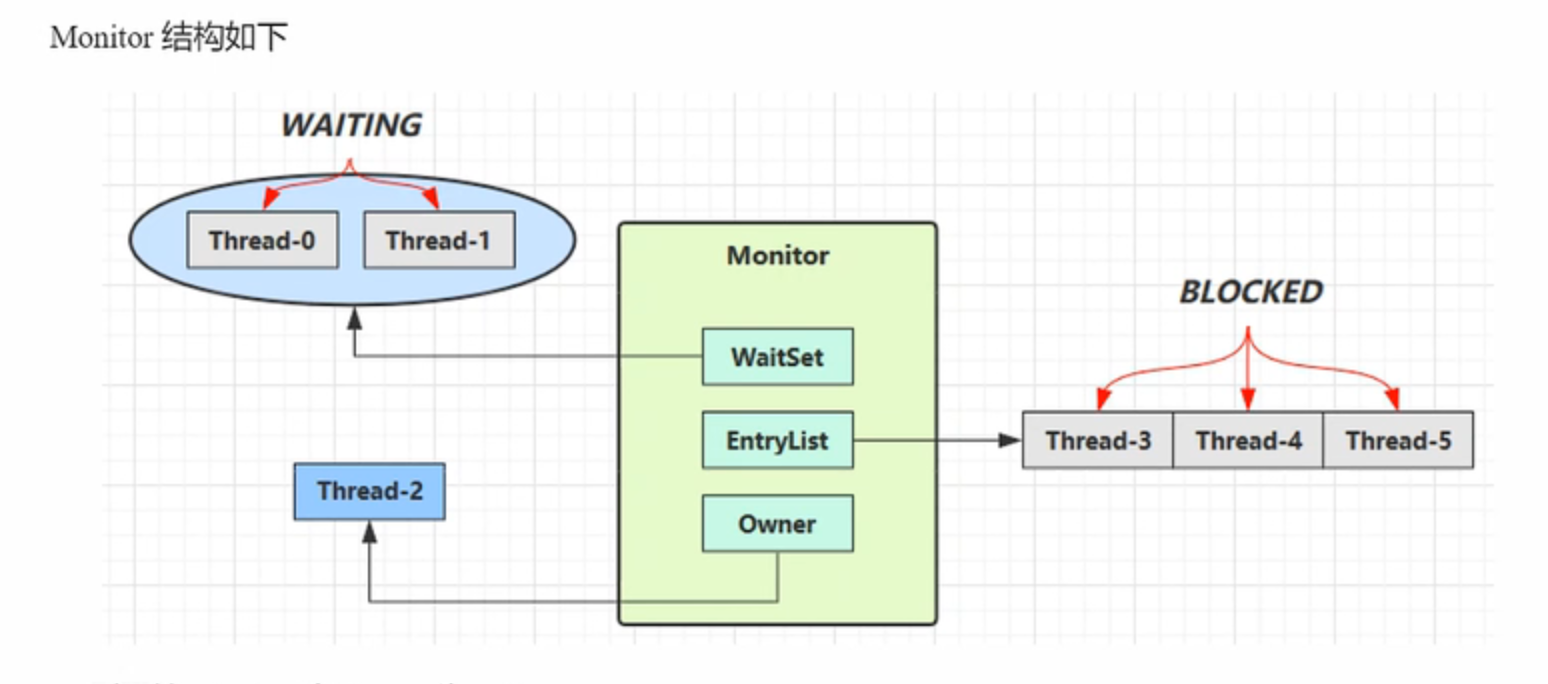

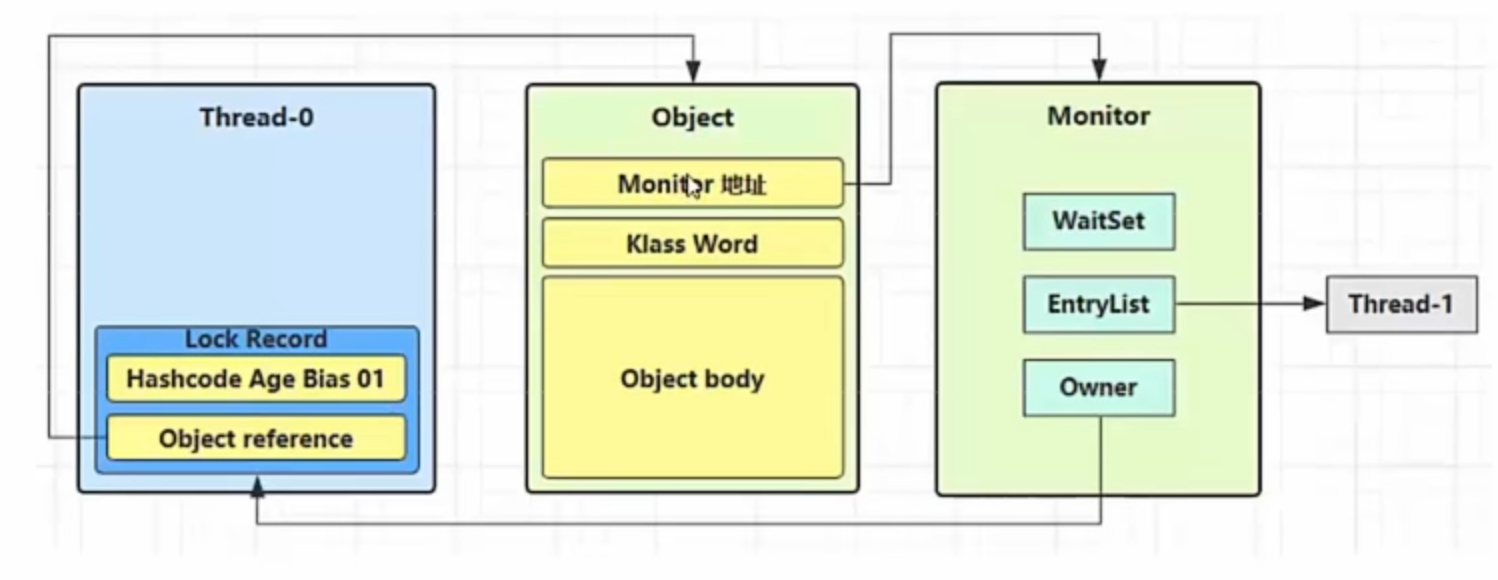

原理之Monitor(锁) Monitor 被翻译为监视器 或管程

每个 Java 对象都可以关联一个 Monitor 对象,如果使用 synchronized 给对象上锁(重量级)之后,该对象头的 Mark Word 中就被设置指向 Monitor 对象的指针

Monitor锁:实际上对象不是真正的锁,对象只是在对象头中保存了真正的锁的引用

Monitor 结构如下

如何通过Monitor锁来实现线程安全呢(加锁原理&&实现原理)?

1.如果一个线程想要加锁,那么他就会跟Monitor锁形成关联(关联就是对象头会保存Monitor锁的引用)

2.线程和锁形成关联后,线程会通过锁的Owner值判断该锁是否已经有主人了(是否被其他线程占有了),如果没有Owner为null,证明该锁没有主人,线程就会把Owner值设置为自己的线程id,标识自己获取了这把锁

3.当另一个线程也想要加锁时,那么该线程也会跟同一个Monitor锁形成关联,通过判断锁的Owner值判断锁是否已经被其他线程占有,如果Owner值不为空,说明已经被其他线程占有,那么此线程就会将自己的线程状态从运行状态切换为阻塞状态并进入Monitor锁的等待队列EntryList中

4.占有锁的线程如何释放锁?释放锁会做些什么操作?

占有锁的线程会将Owner值重写置为Null,并唤醒等待队列中正在等待的线程,然后接触和Monitor锁的关联,此时已经被唤醒的线程会重新竞争锁

小细节:

因为对象头的存储空间有限,对象头是使用本来存储 hashcode:25 | age:4 | biased_lock:0 的空间来存储Monitor锁的引用,那么对象头本来的hashcode,age,biased_lock的数据是交给了Monitor锁来暂时存储的,等到释放锁时二者再重新交换,恢复对象头的MarkWork结构

注意 :

synchronized 必须是进入同一个对象的 monitor 才有上述的效果

不加 synchronized 的对象不会关联监视器,不遵从以上规则

原理之 synchronized 从JVM的字节码角度 讲述synchronized原理

1 2 3 4 5 6 7 static final Object lock = new Object ();static int counter = 0 ;public static void main (String[] args) { synchronized (lock) { counter++; } }

对应的字节码为

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 public static void main (java.lang.String[]) ;descriptor: ([Ljava/lang/String;)V flags: ACC_PUBLIC, ACC_STATIC Code: stack=2 , locals=3 , args_size=1 0 : getstatic #2 3 : dup 4 : astore_1 5 : monitorenter 6 : getstatic #3 9 : iconst_1 10 : iadd 11 : putstatic #3 14 : aload_1 15 : monitorexit 16 : goto 24 19 : astore_2 20 : aload_1 21 : monitorexit 22 : aload_2 23 : athrow 24 : return Exception table: from to target type 6 16 19 any 19 22 19 any LineNumberTable: line 8 : 0 line 9 : 6 line 10 : 14 line 11 : 24 LocalVariableTable: Start Length Slot Name Signature 0 25 0 args [Ljava/lang/String; StackMapTable: number_of_entries = 2 frame_type = 255 offset_delta = 19 locals = [ class "[Ljava/lang/String;" , class java /lang/Object ] stack = [ class java /lang/Throwable ] frame_type = 250 offset_delta = 4

从JVM的字节码清晰可以看出加锁的原理

加锁过程就是对象头(MarkWork结构属于对象头的内部结构)保存了Monitor锁的引用

解锁过程就是唤醒等待队列中的线程并解除跟Monitor锁的关联(重置对象头的MarkWork结构)

重置对象头的MarkWork结构实际上就是将对象头中存储的Mointor锁引用和锁暂时存储的对象头的MarkWork结构信息进行交换,恢复对象头MarkWork结构的信息

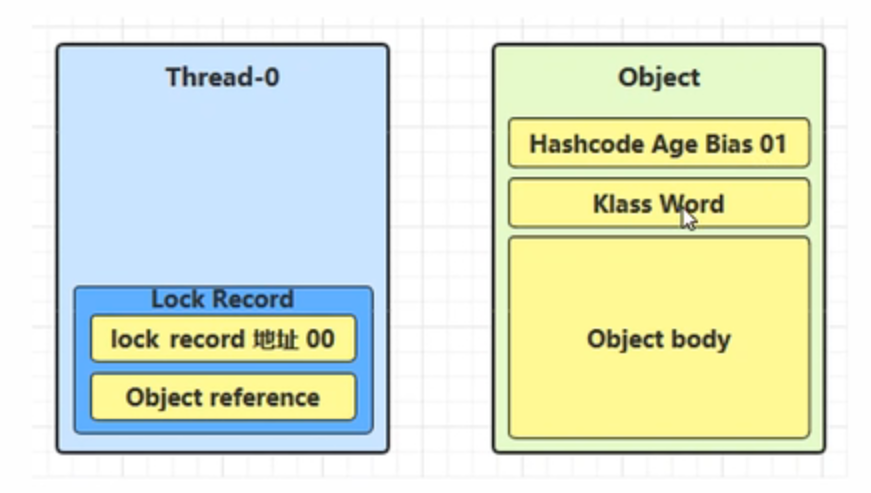

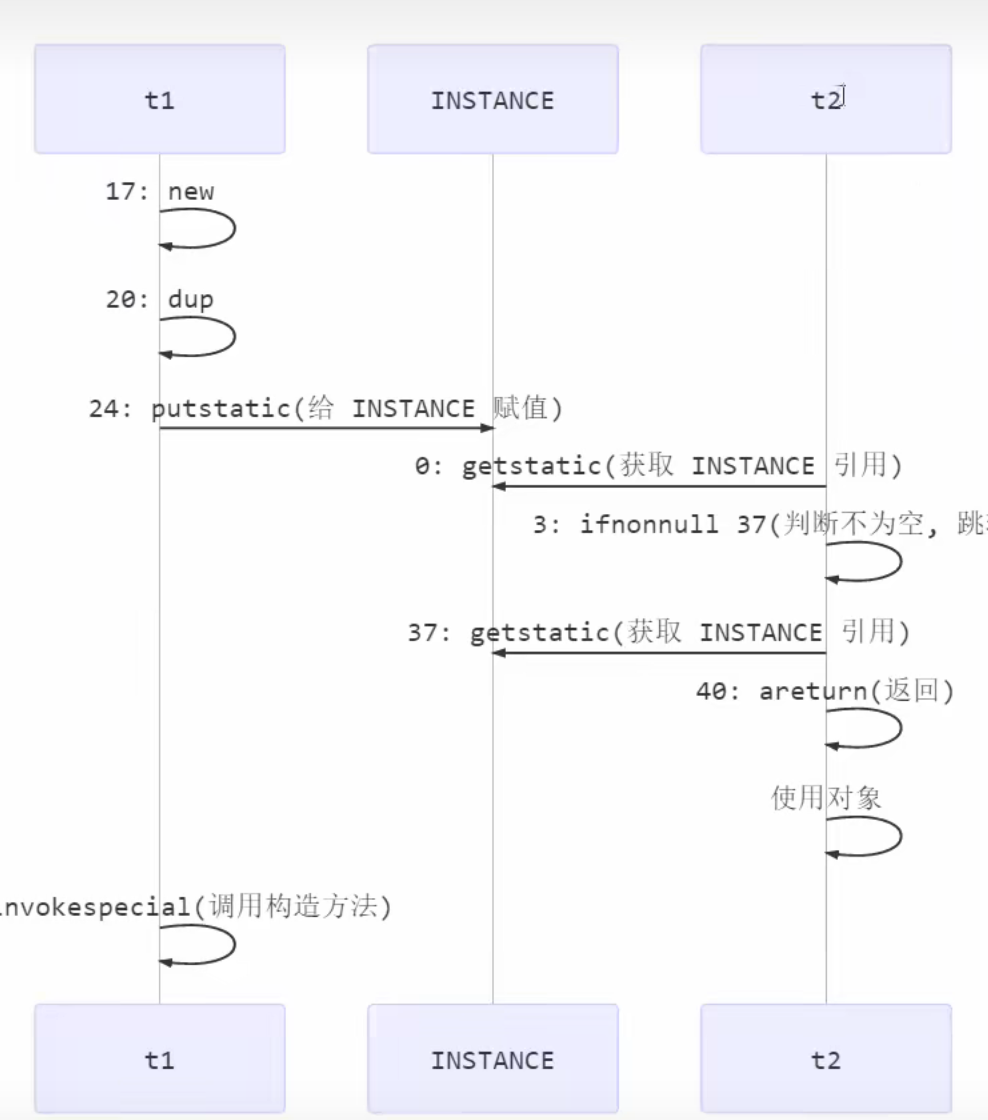

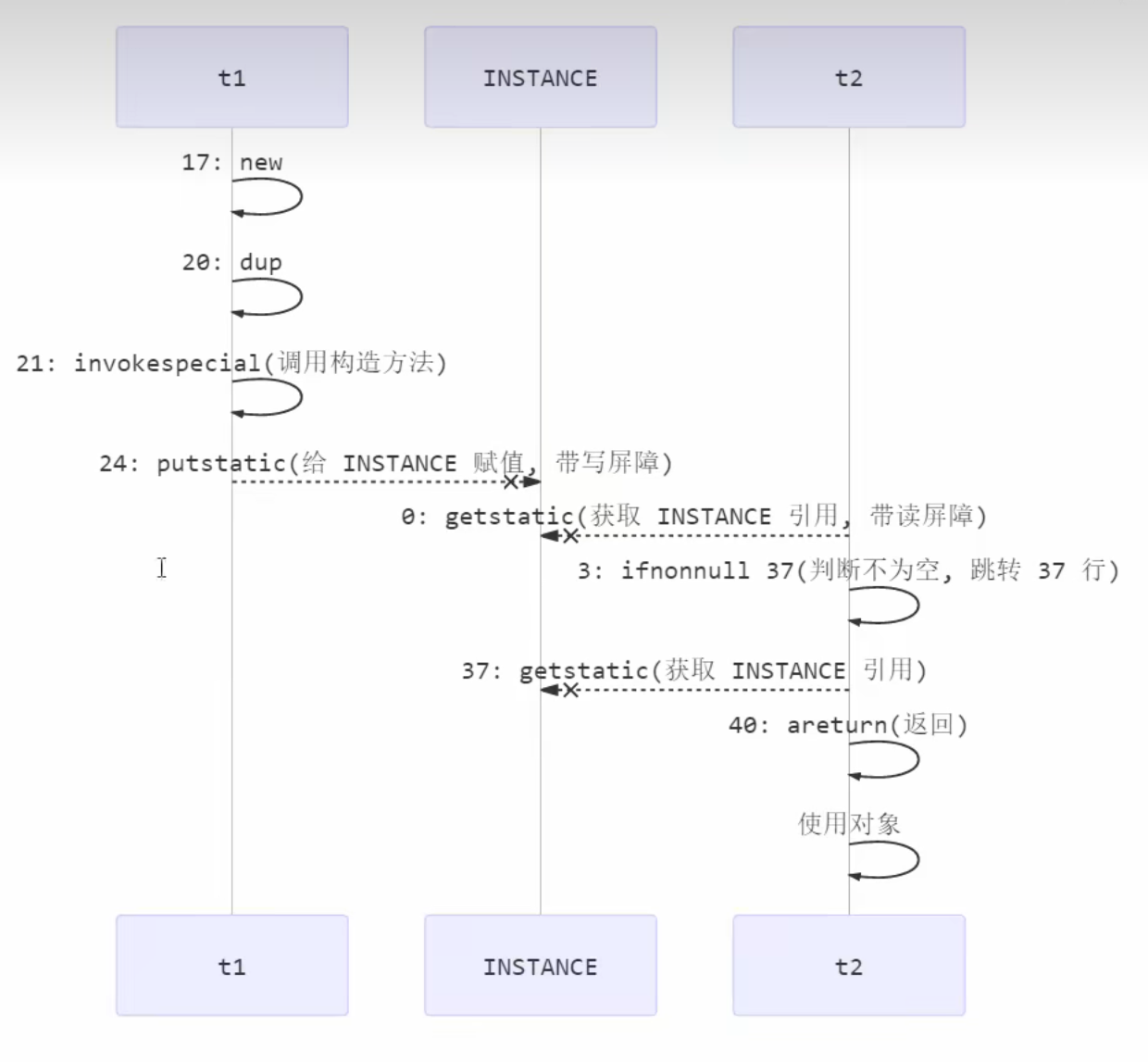

原理之 synchronized 进阶 轻量级锁 轻量级锁的使用场景:

如果一个对象虽然有多线程要加锁,但他们加锁的时间是错开的,也就是不存在多线程同时 访问共享资源的情况,就基本不会出现线程安全问题,那么就可以使用轻量级锁来优化重量级的Monitor锁

为什么需要优化Monitor锁?

Monitor锁属于操作系统层面的锁,涉及操作系统的资源调配和线程的上下文切换,对性能的消耗是非常大的,所以称其为重量级的锁

为什么明明已经不存在同时访问共享资源的情况,也就是不存在线程安全问题了,还要加轻量级锁呢?

因为我们不能保证一定没有同时 访问共享资源的情况,要做好如果真的出现同时访问共享资源的安全处理

轻量级锁加锁原理:

1.轻量级锁是使用线程栈的一个锁记录结构来实现的 ,每一个栈的栈帧都会包含一个锁记录结构

2.线程如果想要加锁,首先先判断锁对象的对象头MarkWork结构是否已经保存了其他锁记录的引用信息,如果已经保存了其他锁记录的引用信息,证明该锁已经被其他线程持有,加锁失败

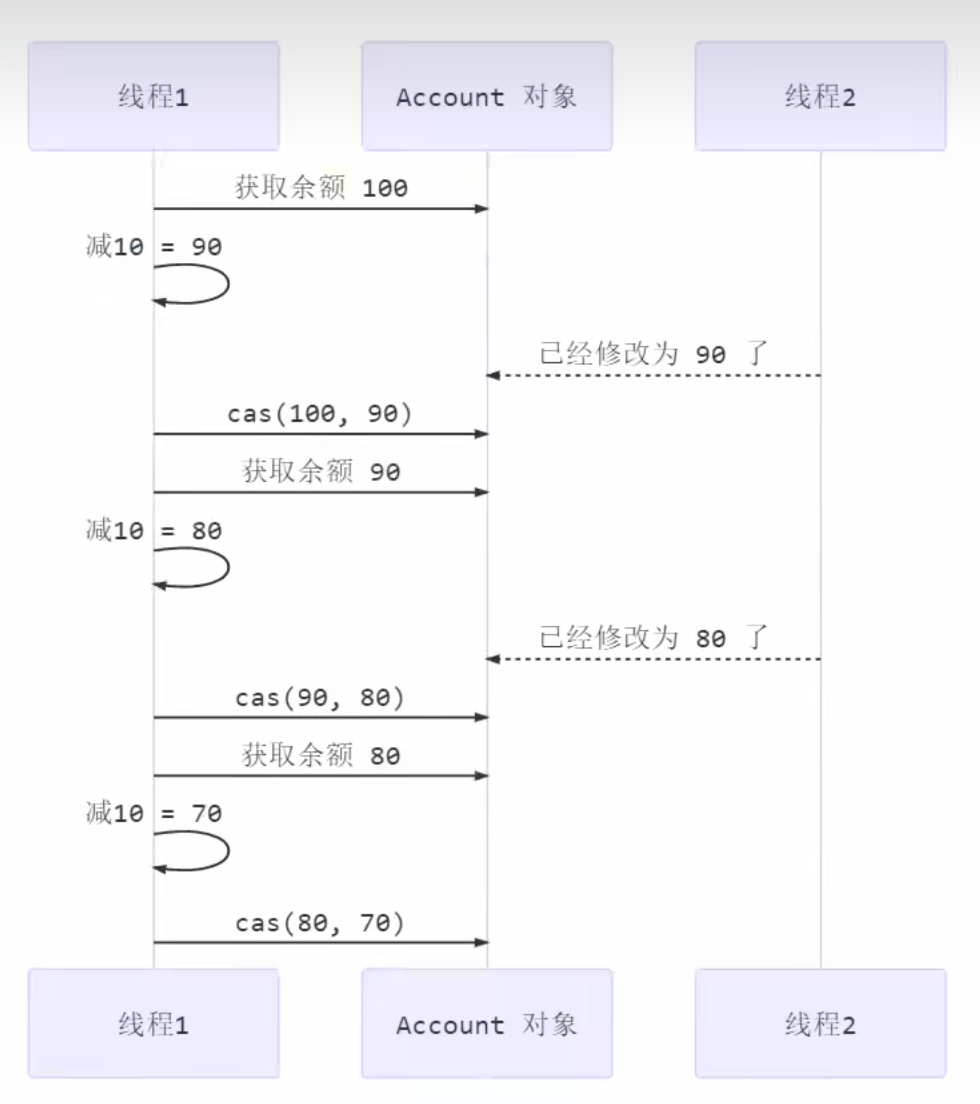

3.如果没有保存其他锁记录的引用信息,则让锁记录和锁对象进行CAS操作,如果CAS操作成功,则标识着线程成功加锁,如果CAS操作失败则加锁失败

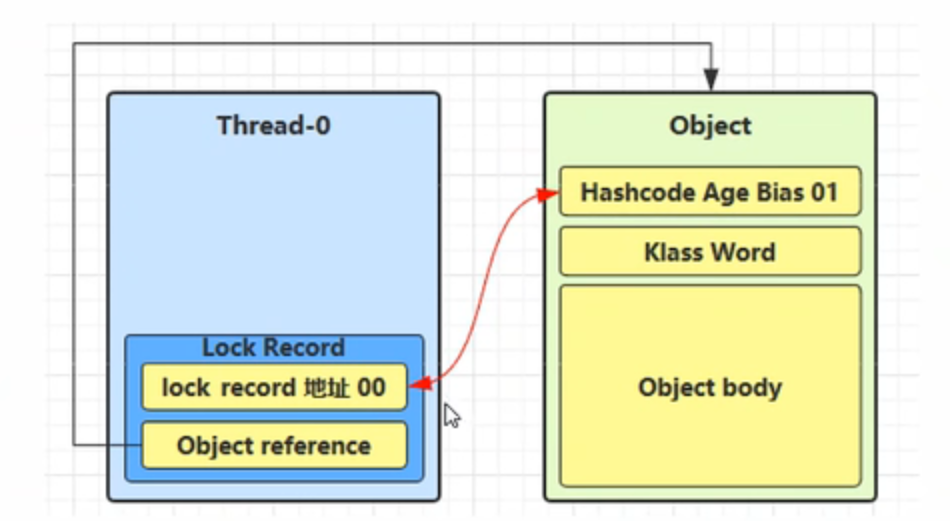

CAS操作分为三步:

1.获取锁对象的对象头MarkWork结构的值

2.将获取到的MarkWrok结构的值与锁对象的MarkWork结构的值相比较,如果相同则证明在加锁过程中没有其他线程干扰

3.如果相同则会让锁记录的引用地址信息和锁对象的对象头MarkWork结构信息进行交换,交换成功即上锁成功

轻量级锁解锁原理

锁记录和锁对象使用CAS操作,如果交换成功则解锁成功,如果交换失败,则说明轻量级锁已经升级为重量级锁,进入重量级锁的解锁流程(重量级级锁的解锁原理上面有)

细节:

如果轻量锁加锁失败则会进行锁膨胀 or 累加锁的重入次数LockRecord

如果是因为同一个线程重复加锁,则会累加锁的重入次数,如果是因为有其他线程同时竞争锁(同时访问共享资源),则会进行锁膨胀,锁膨胀就是将轻量级锁升级为重量级锁。因为存在线程安全问题,只能升级为重量级锁解决线程安全问题了

案例演示

轻量级锁对使用者是透明的,即语法仍然是 synchronized

假设有两个方法同步块,利用同一个对象加锁

1 2 3 4 5 6 7 8 9 10 11 12 static final Object obj = new Object ();public static void method1 () { synchronized ( obj ) { method2(); } } public static void method2 () { synchronized ( obj ) { } }

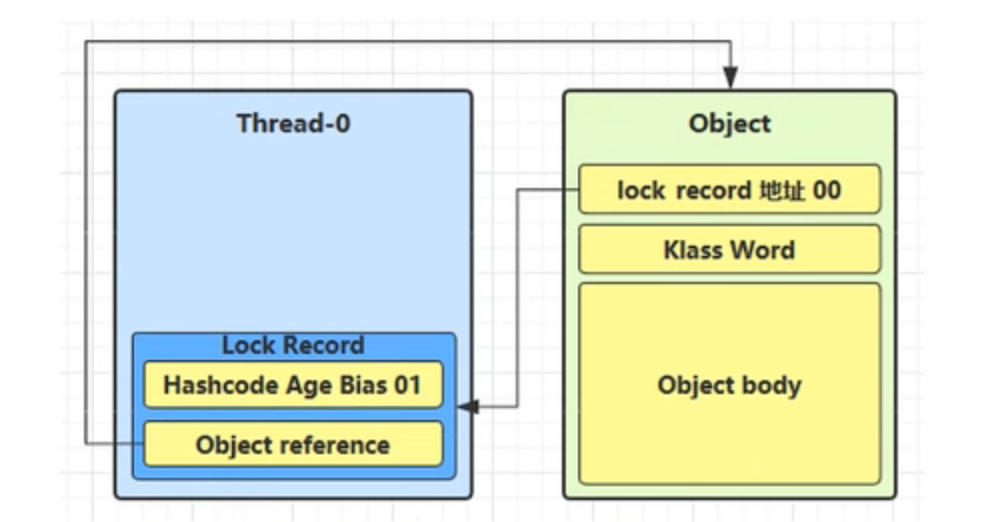

创建锁记录(Lock Record)对象,每个线程栈的栈帧都会包含一个锁记录的结构,内部可以存储锁定对象的 Mark Word

让锁记录中 Object reference 指向锁对象,并尝试用 cas 替换 Object 的 Mark Word,将 Mark Word 的值存 入锁记录

如果 cas 替换成功,对象头中存储了 锁记录地址和状态 00 ,表示由该线程给对象加锁,这时图示如下

如果 cas 失败,有两种情况

如果是其它线程已经持有了该 Object 的轻量级锁,这时表明有竞争,进入锁膨胀过程

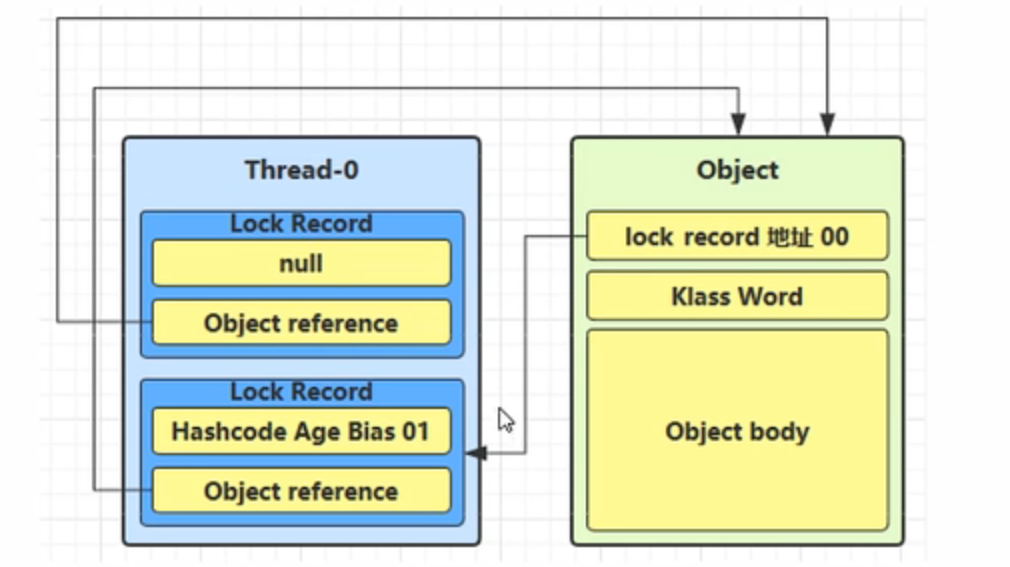

如果是自己执行了 synchronized 锁重入,那么再添加一条 Lock Record 作为重入的计数

当退出 synchronized 代码块(解锁时)如果有取值为 null 的锁记录,表示有重入,这时重置锁记录,表示重 入计数减一

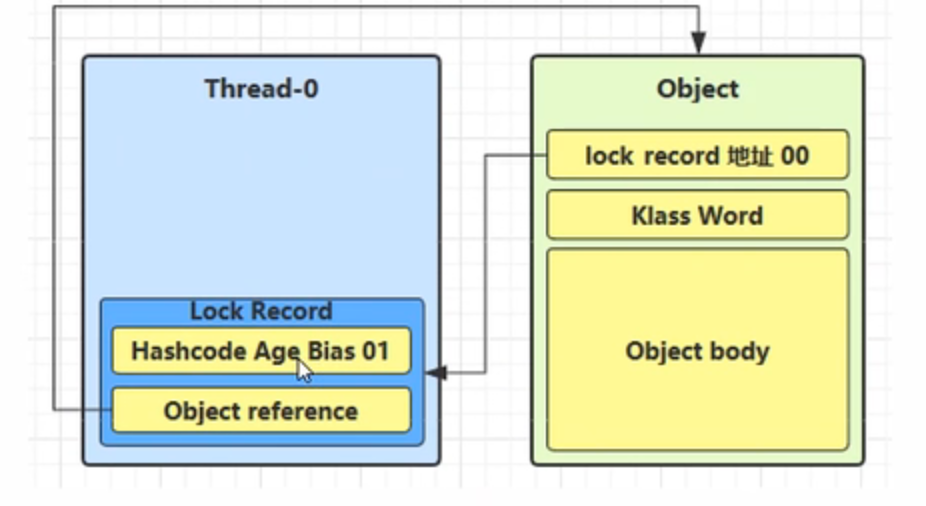

当退出 synchronized 代码块(解锁时)锁记录的值不为 null,这时使用cas将Mark Word的值恢复给对象头

成功,则解锁成功

失败,说明轻量级锁进行了锁膨胀或已经升级为重量级锁,进入重量级锁解锁流程

锁膨胀 如果在尝试加轻量级锁的过程中,CAS 操作无法成功,这时一种情况就是有其它线程为此对象加上了轻量级锁(有竞争 ),这时需要进行锁膨胀,将轻量级锁变为重量级锁。

1 2 3 4 5 6 static Object obj = new Object ();public static void method1 () { synchronized ( obj ) { } }

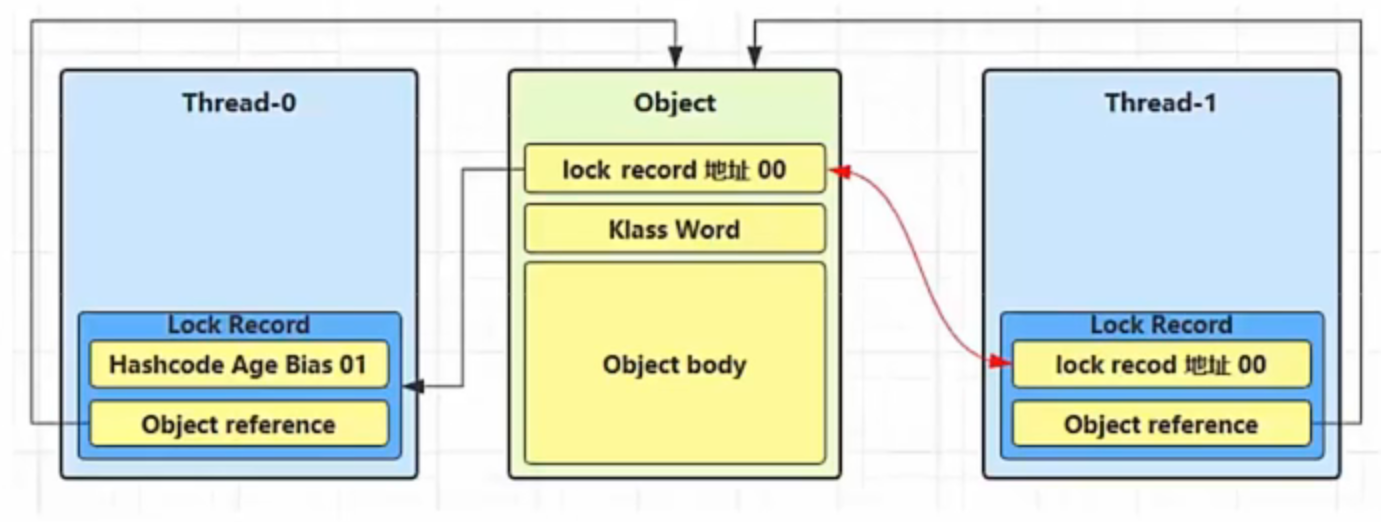

当 Thread-1 进行轻量级加锁时,Thread-0 已经对该对象加了轻量级锁

这时 Thread-1 加轻量级锁失败,进入锁膨胀流程

1.即为Object 对象(锁对象)申请 Monitor 锁 ,让 Object 指向重量级锁地址 (锁对象不再保存锁记录的引用地址)

2.然后自己进入 Monitor 的 EntryList 等待队列 中,并将自己的线程状态切换为阻塞状态

3.当 Thread-0 退出同步块解锁时,使用 cas 将 Mark Word 的值恢复给对象头,失败。这时会进入重量级解锁流程 ,即按照 Monitor 地址找到 Monitor 对象,设置 Owner 为 null,唤醒 EntryList 中 BLOCKED 线程

自旋优化 重量级锁竞争的时候,还可以使用自旋来进行优化,如果当前线程自旋成功(即这时候持锁线程已经退出了同步 块,释放了锁),这时当前线程就可以避免阻塞

实质上是通过避免线程状态的切换(从运行态切换为阻塞太),从而节约操作系统的资源,进而提高操作的性能

自旋重试成功的情况

线程1 ( core 1上)

对象Mark

线程2 ( core 2上)

-

10(重量锁)

-

访问同步块,获取monitor

10(重量锁)重量锁指针

-

成功(加锁)

10(重量锁)重量锁指针

-

执行同步块

10(重量锁)重量锁指针

-

执行同步块

10(重量锁)重量锁指针

访问同步块,获取 monitor

执行同步块

10(重量锁)重量锁指针

自旋重试

执行完毕

10(重量锁)重量锁指针

自旋重试

成功(解锁)

01(无锁)

自旋重试

-

10(重量锁)重量锁指针

成功(加锁)

-

10(重量锁)重量锁指针

执行同步块

-

…

…

自旋重试失败的情况

线程1 ( core 1上)

对象Mark

线程2( core 2上)

-

10(重量锁)

-

访问同步块,获取monitor

10(重量锁)重量锁指针

-

成功(加锁)

10(重量锁)重量锁指针

-

执行同步块

10(重量锁)重量锁指针

-

执行同步块

10(重量锁)重量锁指针

访问同步块,获取monitor

执行同步块

10(重量锁)重量锁指针

自旋重试

执行同步块

10(重量锁)重量锁指针

自旋重试

执行同步块

10(重量锁)重量锁指针

自旋重试

执行同步块

10(重量锁)重量锁指针

阻塞

-

…

…

自旋会占用 CPU 时间,单核 CPU 自旋就是浪费,多核 CPU 自旋才能发挥优势

在 Java 6 之后自旋锁是自适应的,比如对象刚刚的一次自旋操作成功过,那么认为这次自旋成功的可能性会 高,就多自旋几次;反之,就少自旋甚至不自旋,总之,比较智能 Java 7 之后不能控制是否开启自旋功能

偏向锁 轻量级锁在没有竞争时(就自己这个线程),每次重入仍然需要执行 CAS 操作,而CAS操作仍会消耗一定的性能

优化方案: 既然只有一个线程在操作了,并不存在其他线程干扰的问题,那能不能在重入锁时不需要执行CAS操作呢,只需要判断一下是不是自己的锁即可呢?

答案是能,用偏向锁优化轻量级锁即可

偏向锁来做进一步优化轻量级锁:

只有第一次使用 CAS 将线程 ID 设置到对象的 Mark Word 头,之后发现这个线程 ID是自己的就表示没有竞争,不用重新CAS。以后只要不发生竞争,这个对象就归该线程所有

例如:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 static final Object obj = new Object ();public static void m1 () { synchronized ( obj ) { m2(); } } public static void m2 () { synchronized ( obj ) { m3(); } } public static void m3 () { synchronized ( obj ) { } }

轻量级锁优化前后对比

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 graph LR subgraph 偏向锁 t5("m1内调用synchronized(obj)") t6("m2内调用synchronized(obj)") t7("m2内调用synchronized(obj)") t8(对象) t5 -.用ThreadID替换MarkWord.-> t8 t6 -.检查ThreadID是否是自己.-> t8 t7 -.检查ThreadID是否是自己.-> t8 end subgraph 轻量级锁 t1("m1内调用synchronized(obj)") t2("m2内调用synchronized(obj)") t3("m2内调用synchronized(obj)") t1 -.生成锁记录.-> t1 t2 -.生成锁记录.-> t2 t3 -.生成锁记录.-> t3 t4(对象) t1 -.用锁记录替换markword.-> t4 t2 -.用锁记录替换markword.-> t4 t3 -.用锁记录替换markword.-> t4 end

偏向状态 回忆一下对象头格式

1 2 3 4 5 6 7 8 9 10 11 12 13 |-------------------------------------------------------------------- |--------------------| Mark Word (64 bits) | State ||-------------------------------------------------------------------- |--------------------| unused: 25 | hashcode:31 | unused: 1 | age:4 | biased_lock: 0 | 01 | Normal |-------------------- || thread:54 | epoch: 2 | unused:1 | age: 4 | biased_lock:1 | 01 | Biased | |-------------------------------------------------------------------- |--------------------| ptr_to_lock_record: 62 | 00 | Lightweight Locked |-------------------- || ptr_to_heavyweight_monitor:62 | 10 | Heavyweight Locked | |-------------------------------------------------------------------- |--------------------| 11 | Marked for GC |-------------------- |

一个对象创建时:

如果开启了偏向锁(默认开启 ),那么对象创建后,markword 值为 0x05 即最后 3 位为 101,这时它的 thread、epoch、age 都为 0

偏向锁是默认是延迟的,不会在程序启动时立即生效,如果想避免延迟,可以加 VM 参数- XX:BiasedLockingStartupDelay=0来禁用延迟

如果没有开启偏向锁,那么对象创建后,markword 值为 0x01 即最后 3 位为 001,这时它的 hashcode、 age 都为 0,第一次用到 hashcode 时才会赋值

实质就是用对象头的MarkWork结构的倒数第三位表示是否启动偏向锁,如果是0表示未启用,如果是1表示启用偏向锁

1) 测试延迟特性

2) 测试偏向锁

利用 jol 第三方工具来查看对象头信息(注意这里我扩展了 jol 让它输出更为简洁)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 public static void main (String[] args) throws IOException { Dog d = new Dog (); ClassLayout classLayout = ClassLayout.parseInstance(d); new Thread (() -> { log.debug("synchronized 前" ); System.out.println(classLayout.toPrintableSimple(true )); synchronized (d) { log.debug("synchronized 中" ); System.out.println(classLayout.toPrintableSimple(true )); } log.debug("synchronized 后" ); System.out.println(classLayout.toPrintableSimple(true )); }, "t1" ).start(); }

1 2 3 4 5 6 11:08:58.117 c.TestBiased [t1] - synchronized 前 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000101 11:08:58.121 c.TestBiased [t1] - synchronized 中 00000000 00000000 00000000 00000000 00011111 11101011 11010000 00000101 11:08:58.121 c.TestBiased [t1] - synchronized 后 00000000 00000000 00000000 00000000 00011111 11101011 11010000 00000101

注意

处于偏向锁的对象解锁后,线程 id 仍存储于对象头中

3)测试禁用

在上面测试代码运行时在添加 VM 参数 -XX:-UseBiasedLocking 禁用偏向锁

输出

1 2 3 4 5 6 11:13:10.018 c.TestBiased [t1] - synchronized 前 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 11:13:10.021 c.TestBiased [t1] - synchronized 中 00000000 00000000 00000000 00000000 00100000 00010100 11110011 10001000 11:13:10.021 c.TestBiased [t1] - synchronized 后 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001

4)测试 hashCode

正常状态对象一开始是没有 hashCode 的,第一次调用才生成

撤销 - 调用对象 hashCode 调用了对象的 hashCode,但偏向锁的对象 MarkWord 中存储的是线程 id,如果调用 hashCode 会导致偏向锁被 撤销

因为对象头的空间有限,如果存储了hashCode就没有额外的空间存储线程id了

轻量级锁会在锁记录中记录 hashCode

重量级锁会在 Monitor 中记录 hashCode

在调用 hashCode 后使用偏向锁,记得去掉-XX:-UseBiasedLocking

输出

1 2 3 4 5 6 7 11:22:10.386 c.TestBiased [main] - 调用 hashCode:1778535015 11:22:10.391 c.TestBiased [t1] - synchronized 前 00000000 00000000 00000000 01101010 00000010 01001010 01100111 00000001 11:22:10.393 c.TestBiased [t1] - synchronized 中 00000000 00000000 00000000 00000000 00100000 11000011 11110011 01101000 11:22:10.393 c.TestBiased [t1] - synchronized 后 00000000 00000000 00000000 01101010 00000010 01001010 01100111 00000001

撤销 - 其它线程使用对象 当有其它线程使用偏向锁对象时,会将偏向锁升级为轻量级锁

因为有其他锁使用偏向锁对象,证明存在多个线程同时访问共享资源的去情况,必须将锁升级未轻量级锁,只有轻量级锁在遇到线程安全问题时将锁升级重量级锁

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 private static void test2 () throws InterruptedException { Dog d = new Dog (); Thread t1 = new Thread (() -> { synchronized (d) { log.debug(ClassLayout.parseInstance(d).toPrintableSimple(true )); } synchronized (TestBiased.class) { TestBiased.class.notify(); } }, "t1" ); t1.start(); Thread t2 = new Thread (() -> { synchronized (TestBiased.class) { try { TestBiased.class.wait(); } catch (InterruptedException e) { e.printStackTrace(); } } log.debug(ClassLayout.parseInstance(d).toPrintableSimple(true )); synchronized (d) { log.debug(ClassLayout.parseInstance(d).toPrintableSimple(true )); } log.debug(ClassLayout.parseInstance(d).toPrintableSimple(true )); }, "t2" ); t2.start(); }

输出

1 2 3 4 [t1] - 00000000 00000000 00000000 00000000 00011111 01000001 00010000 00000101 [t2] - 00000000 00000000 00000000 00000000 00011111 01000001 00010000 00000101 [t2] - 00000000 00000000 00000000 00000000 00011111 10110101 11110000 01000000 [t2] - 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001

撤销 - 调用 wait/notify 因为wait/notify本身就是重量级锁的api,如果在偏向锁中要想使用重量级锁的api,必须将偏向锁升级为重量级锁

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 public static void main (String[] args) throws InterruptedException { Dog d = new Dog (); Thread t1 = new Thread (() -> { log.debug(ClassLayout.parseInstance(d).toPrintableSimple(true )); synchronized (d) { log.debug(ClassLayout.parseInstance(d).toPrintableSimple(true )); try { d.wait(); } catch (InterruptedException e) { e.printStackTrace(); } log.debug(ClassLayout.parseInstance(d).toPrintableSimple(true )); } }, "t1" ); t1.start(); new Thread (() -> { try { Thread.sleep(6000 ); } catch (InterruptedException e) { e.printStackTrace(); } synchronized (d) { log.debug("notify" ); d.notify(); } }, "t2" ).start(); }

输出

1 2 3 4 [t1] - 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000101 [t1] - 00000000 00000000 00000000 00000000 00011111 10110011 11111000 00000101 [t2] - notify [t1] - 00000000 00000000 00000000 00000000 00011100 11010100 00001101 11001010

批量重偏向 如果对象虽然被多个线程访问,但没有竞争,这时偏向了线程 T1 的对象仍有机会重新偏向 T2,重偏向会重置对象 的 Thread ID

当撤销偏向锁阈值超过 20 次后,jvm 会这样觉得,我是不是偏向错了呢,于是会在给这些对象加锁时重新偏向至 加锁线程

案例演示

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 private static void test3 () throws InterruptedException { Vector<Dog> list = new Vector <>(); Thread t1 = new Thread (() -> { for (int i = 0 ; i < 30 ; i++) { Dog d = new Dog (); list.add(d); synchronized (d) { log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); } } synchronized (list) { list.notify(); } }, "t1" ); t1.start(); Thread t2 = new Thread (() -> { synchronized (list) { try { list.wait(); } catch (InterruptedException e) { e.printStackTrace(); } } log.debug("===============> " ); for (int i = 0 ; i < 30 ; i++) { Dog d = list.get(i); log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); synchronized (d) { log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); } log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); } }, "t2" ); t2.start(); }

输出验证

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 [t1] - 0 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 1 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 2 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 3 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 4 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 5 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 6 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 7 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 8 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 9 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 10 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 11 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 12 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 13 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 14 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 15 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 16 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 17 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 18 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 19 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 20 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 21 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 22 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 23 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 24 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 25 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 26 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 27 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 28 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t1] - 29 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - ===============> [t2] - 0 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 0 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 0 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 1 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 1 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 1 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 2 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 2 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 2 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 3 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 3 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 3 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 4 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 4 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 4 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 5 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 5 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 5 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 6 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 6 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 6 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 7 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 7 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 7 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 8 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 8 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 8 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 9 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 9 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 9 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 10 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 10 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 10 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 11 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 11 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 11 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 12 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 12 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 12 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 13 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 13 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 13 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 14 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 14 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 14 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 15 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 15 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 15 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 16 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 16 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 16 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 17 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 17 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 17 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 18 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 18 00000000 00000000 00000000 00000000 00100000 01011000 11110111 00000000 [t2] - 18 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000001 [t2] - 19 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 19 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 19 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 20 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 20 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 20 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 21 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 21 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 21 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 22 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 22 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 22 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 23 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 23 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 23 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 24 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 24 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 24 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 25 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 25 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 25 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 26 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 26 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 26 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 27 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 27 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 27 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 28 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 28 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 28 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 29 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 [t2] - 29 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101 [t2] - 29 00000000 00000000 00000000 00000000 00011111 11110011 11110001 00000101

批量撤销 当撤销偏向锁阈值超过 40 次后,jvm 会这样觉得,自己确实偏向错了,根本就不该偏向。于是整个类的所有对象 都会变为不可偏向的,新建的对象也是不可偏向的

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 static Thread t1,t2,t3;private static void test4 () throws InterruptedException { Vector<Dog> list = new Vector <>(); int loopNumber = 39 ; t1 = new Thread (() -> { for (int i = 0 ; i < loopNumber; i++) { Dog d = new Dog (); list.add(d); synchronized (d) { log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); } } LockSupport.unpark(t2); }, "t1" ); t1.start(); t2 = new Thread (() -> { LockSupport.park(); log.debug("===============> " ); for (int i = 0 ; i < loopNumber; i++) { Dog d = list.get(i); log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); synchronized (d) { log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); } log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); } LockSupport.unpark(t3); }, "t2" ); t2.start(); t3 = new Thread (() -> { LockSupport.park(); log.debug("===============> " ); for (int i = 0 ; i < loopNumber; i++) { Dog d = list.get(i); log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); synchronized (d) { log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); } log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintableSimple(true )); } }, "t3" ); t3.start(); t3.join(); log.debug(ClassLayout.parseInstance(new Dog ()).toPrintableSimple(true )); }

参考资料

https://github.com/farmerjohngit/myblog/issues/12

https://www.cnblogs.com/LemonFive/p/11246086.html

https://www.cnblogs.com/LemonFive/p/11248248.html

[偏向锁论文](Eliminating Synchronization-Related Atomic Operations with Biased Locking and Bulk Rebiasing (oracle.com) )

锁消除 锁消除:Java编译器会自行优化实际上不需要加锁的代码

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 @Fork(1) @BenchmarkMode(Mode.AverageTime) @Warmup(iterations=3) @Measurement(iterations=5) @OutputTimeUnit(TimeUnit.NANOSECONDS) public class MyBenchmark { static int x = 0 ; @Benchmark public void a () throws Exception { x++; } @Benchmark public void b () throws Exception { Object o = new Object (); synchronized (o) { x++; } } }

a方法没有加锁和b方法加了锁的性能对比,二者性能差异不大,证明Java编译器底层对b方法进行了消除锁的优化

java -jar benchmarks.jar

1 2 3 Benchmark Mode Samples Score Score error Units c.i.MyBenchmark.a avgt 5 1.542 0.056 ns/op c.i.MyBenchmark.b avgt 5 1.518 0.091 ns/op

java -XX:-EliminateLocks -jar benchmarks.jar

1 2 3 Benchmark Mode Samples Score Score error Units c.i.MyBenchmark.a avgt 5 1.507 0.108 ns/op c.i.MyBenchmark.b avgt 5 16.976 1.572 ns/op

锁粗化

对相同对象多次加锁,导致线程发生多次重入,可以使用锁粗化方式来优化,这不同于之前讲的细分锁的粒度。

总结 1.Monitor是什么?

Monitor是一种重量级锁的数据结构,他有waitset等待队列,entrylist阻塞队列,owner锁的主人三种属性,waitset存储阻塞类型为wating,timed_waiting状态的线程,而entrylist则存储blocked状态的线程,owner存储锁的主人,即线程id

2.为什么需要重量级锁Monitor?

因为重量级锁Monitor可以实现线程访问共享资源的串行性,进而解决并发线程中的线程安全问题

3.如何使用重量级锁?

使用synchronized关键字配合重量级锁的相关功能api(如wait,notify,notifyAll)即可,需要深入理解synchronized关键字的原理,重量级锁Monitor的结构以及重量级锁的每一个功能api的实现原理才能合理的使用重量级锁

wait notify 原理之 wait / notify wait/notify是属于重量级锁Monitor的相关功能,所以其原理和重量级锁Monitor结构有很大的关联

Owner 线程发现条件不满足,调用 wait 方法,即可进入 WaitSet等待队列变为 WAITING 状态

BLOCKED 和 WAITING 的线程都处于阻塞状态,不占用 CPU 时间片 BLOCKED 线程会在 Owner 线程释放锁时唤醒 WAITING 线程会在 Owner 线程调用 notify 或 notifyAll 时唤醒,但唤醒后并不意味者立刻获得锁,仍需进入 EntryList 重新竞争

API 介绍

obj.wait() 让进入 object 监视器的线程到 waitSet 等待 obj.notify() 在 object 上正在 waitSet 等待的线程中挑一个唤醒 obj.notifyAll() 让 object 上正在 waitSet 等待的线程全部唤醒

它们都是线程之间进行协作的手段,都属于 Object 对象的方法,且都需要获取了重量级锁资源之后才能调用

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 final static Object obj = new Object ();public static void main (String[] args) { new Thread (() -> { synchronized (obj) { log.debug("执行...." ); try { obj.wait(); } catch (InterruptedException e) { e.printStackTrace(); } log.debug("其它代码...." ); } }).start(); new Thread (() -> { synchronized (obj) { log.debug("执行...." ); try { obj.wait(); } catch (InterruptedException e) { e.printStackTrace(); } log.debug("其它代码...." ); } }).start(); sleep(2 ); log.debug("唤醒 obj 上其它线程" ); synchronized (obj) { obj.notify(); } }

notify 的一种结果

1 2 3 4 20:00:53.096 [Thread-0] c.TestWaitNotify - 执行.... 20:00:53.099 [Thread-1] c.TestWaitNotify - 执行.... 20:00:55.096 [main] c.TestWaitNotify - 唤醒 obj 上其它线程 20:00:55.096 [Thread-0] c.TestWaitNotify - 其它代码....

notifyAll 的结果

1 2 3 4 5 19:58:15.457 [Thread-0] c.TestWaitNotify - 执行.... 19:58:15.460 [Thread-1] c.TestWaitNotify - 执行.... 19:58:17.456 [main] c.TestWaitNotify - 唤醒 obj 上其它线程 19:58:17.456 [Thread-1] c.TestWaitNotify - 其它代码.... 19:58:17.456 [Thread-0] c.TestWaitNotify - 其它代码....

wait() 方法会释放对象的锁,进入 WaitSet 等待区,从而让其他线程就机会获取对象的锁。无限制等待,直到 notify 为止

wait(long n) 有时限的等待, 到 n 毫秒后结束等待,或是被 notify

wait notify 的正确用法 开始之前先看看

sleep(long n) 和 wait(long n) 的区别

sleep 是 Thread 方法,而 wait 是 Object 的方法

sleep 不需要强制和 synchronized 配合使用,但 wait 需要 和 synchronized 一起用

sleep 在睡眠的同时,不会释放对象锁的,但 wait 在等待的时候会释放对象锁 它们 状态 TIMED_WAITING

核心共同点:都会让出CPU的执行权

核心区别:sleep方法不会释放锁资源,而wait方法会释放锁资源

step 1 1 2 3 static final Object room = new Object ();static boolean hasCigarette = false ;static boolean hasTakeout = false ;

思考下面的解决方案好不好,为什么?

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 new Thread (() -> { synchronized (room) { log.debug("有烟没?[{}]" , hasCigarette); if (!hasCigarette) { log.debug("没烟,先歇会!" ); sleep(2 ); } log.debug("有烟没?[{}]" , hasCigarette); if (hasCigarette) { log.debug("可以开始干活了" ); } } }, "小南" ).start(); for (int i = 0 ; i < 5 ; i++) { new Thread (() -> { synchronized (room) { log.debug("可以开始干活了" ); } }, "其它人" ).start(); } sleep(1 ); new Thread (() -> { hasCigarette = true ; log.debug("烟到了噢!" ); }, "送烟的" ).start();

输出

1 2 3 4 5 6 7 8 9 10 20:49:49.883 [小南] c.TestCorrectPosture - 有烟没?[false ] 20:49:49.887 [小南] c.TestCorrectPosture - 没烟,先歇会! 20:49:50.882 [送烟的] c.TestCorrectPosture - 烟到了噢! 20:49:51.887 [小南] c.TestCorrectPosture - 有烟没?[true ] 20:49:51.887 [小南] c.TestCorrectPosture - 可以开始干活了 20:49:51.887 [其它人] c.TestCorrectPosture - 可以开始干活了 20:49:51.887 [其它人] c.TestCorrectPosture - 可以开始干活了 20:49:51.888 [其它人] c.TestCorrectPosture - 可以开始干活了 20:49:51.888 [其它人] c.TestCorrectPosture - 可以开始干活了 20:49:51.888 [其它人] c.TestCorrectPosture - 可以开始干活了

其它干活的线程,都要一直阻塞,效率太低(就是因为sleep方法不会释放锁资源) 小南线程必须睡足 2s 后才能醒来,就算烟提前送到,也无法立刻醒来 (sleep方法缺乏notify的及时唤醒机制)

加了 synchronized (room) 后,就好比小南在里面反锁了门睡觉,烟根本没法送进门,main 没加 synchronized 就好像 main 线程是翻窗户进来的

解决方法,使用 wait - notify 机制

step 2 思考下面的实现行吗,为什么?

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 new Thread (() -> { synchronized (room) { log.debug("有烟没?[{}]" , hasCigarette); if (!hasCigarette) { log.debug("没烟,先歇会!" ); try { room.wait(2000 ); } catch (InterruptedException e) { e.printStackTrace(); } } log.debug("有烟没?[{}]" , hasCigarette); if (hasCigarette) { log.debug("可以开始干活了" ); } } }, "小南" ).start(); for (int i = 0 ; i < 5 ; i++) { new Thread (() -> { synchronized (room) { log.debug("可以开始干活了" ); } }, "其它人" ).start(); } sleep(1 ); new Thread (() -> { synchronized (room) { hasCigarette = true ; log.debug("烟到了噢!" ); room.notify(); } }, "送烟的" ).start();

解决了其它干活的线程阻塞的问题 但如果有其它线程也在等待条件呢?

step 3 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 new Thread (() -> { synchronized (room) { log.debug("有烟没?[{}]" , hasCigarette); if (!hasCigarette) { log.debug("没烟,先歇会!" ); try { room.wait(); } catch (InterruptedException e) { e.printStackTrace(); } } log.debug("有烟没?[{}]" , hasCigarette); if (hasCigarette) { log.debug("可以开始干活了" ); } else { log.debug("没干成活..." ); } } }, "小南" ).start(); new Thread (() -> { synchronized (room) { Thread thread = Thread.currentThread(); log.debug("外卖送到没?[{}]" , hasTakeout); if (!hasTakeout) { log.debug("没外卖,先歇会!" ); try { room.wait(); } catch (InterruptedException e) { e.printStackTrace(); } } log.debug("外卖送到没?[{}]" , hasTakeout); if (hasTakeout) { log.debug("可以开始干活了" ); } else { log.debug("没干成活..." ); } } }, "小女" ).start(); sleep(1 ); new Thread (() -> { synchronized (room) { hasTakeout = true ; log.debug("外卖到了噢!" ); room.notify(); } }, "送外卖的" ).start();

输出

1 2 3 4 5 6 7 20:53:12.173 [小南] c.TestCorrectPosture - 有烟没?[false ] 20:53:12.176 [小南] c.TestCorrectPosture - 没烟,先歇会! 20:53:12.176 [小女] c.TestCorrectPosture - 外卖送到没?[false ] 20:53:12.176 [小女] c.TestCorrectPosture - 没外卖,先歇会! 20:53:13.174 [送外卖的] c.TestCorrectPosture - 外卖到了噢! 20:53:13.174 [小南] c.TestCorrectPosture - 有烟没?[false ] 20:53:13.174 [小南] c.TestCorrectPosture - 没干成活...

step 4 1 2 3 4 5 6 7 new Thread (() -> { synchronized (room) { hasTakeout = true ; log.debug("外卖到了噢!" ); room.notifyAll(); } }, "送外卖的" ).start();

输出

1 2 3 4 5 6 7 8 9 20:55:23.978 [小南] c.TestCorrectPosture - 有烟没?[false ] 20:55:23.982 [小南] c.TestCorrectPosture - 没烟,先歇会! 20:55:23.982 [小女] c.TestCorrectPosture - 外卖送到没?[false ] 20:55:23.982 [小女] c.TestCorrectPosture - 没外卖,先歇会! 20:55:24.979 [送外卖的] c.TestCorrectPosture - 外卖到了噢! 20:55:24.979 [小女] c.TestCorrectPosture - 外卖送到没?[true ] 20:55:24.980 [小女] c.TestCorrectPosture - 可以开始干活了 20:55:24.980 [小南] c.TestCorrectPosture - 有烟没?[false ] 20:55:24.980 [小南] c.TestCorrectPosture - 没干成活...

用 notifyAll 仅解决某个线程的唤醒问题,但使用 if + wait 判断仅有一次机会,一旦条件不成立,就没有重新判断的机会了

就比如案例中虽然正确唤醒送外卖的线程,但与此同时也会唤醒送烟的线程,并且其实送烟的线程此时还没有烟这个资源就被唤醒了,应该继续等待下一次的唤醒,但使用if+wait只有一次判断是否有送烟的资源,如果第一次唤醒没有烟的资源送过来,那后续就再也没有机会唤醒送烟的线程了

核心:实际上就是notifyAll会唤醒所有线程,导致除了真正获取到相应的资源的线程可以继续执行外,其他线程都是被虚假唤醒的,应再次进入等待状态(阻塞状态),等待唤醒,而If+wait只有一次判断资源和等待的机会,如果因为虚假唤醒了,就再也没有机会进入等待状态等待相应的资源再唤醒了

解决方法,用 while + wait,当条件不成立,再次 wait

step 5 将 if 改为 while

1 2 3 4 5 6 7 8 if (!hasCigarette) { log.debug("没烟,先歇会!" ); try { room.wait(); } catch (InterruptedException e) { e.printStackTrace(); } }

改动后

1 2 3 4 5 6 7 8 while (!hasCigarette) { log.debug("没烟,先歇会!" ); try { room.wait(); } catch (InterruptedException e) { e.printStackTrace(); } }

只有线程被唤醒才会接着while,不唤醒就是wait,所以不会有cpu空转

输出

1 2 3 4 5 6 7 8 20:58:34.322 [小南] c.TestCorrectPosture - 有烟没?[false ] 20:58:34.326 [小南] c.TestCorrectPosture - 没烟,先歇会! 20:58:34.326 [小女] c.TestCorrectPosture - 外卖送到没?[false ] 20:58:34.326 [小女] c.TestCorrectPosture - 没外卖,先歇会! 20:58:35.323 [送外卖的] c.TestCorrectPosture - 外卖到了噢! 20:58:35.324 [小女] c.TestCorrectPosture - 外卖送到没?[true ] 20:58:35.324 [小女] c.TestCorrectPosture - 可以开始干活了 20:58:35.324 [小南] c.TestCorrectPosture - 没烟,先歇会!

正确用法 1 2 3 4 5 6 7 8 9 10 11 12 synchronized (lock) { while (条件不成立) { lock.wait(); } } synchronized (lock) { lock.notifyAll(); }

总结 1.wait/notify/notifyAll是什么?

wait/notify/notifyAll是重量级锁的功能api,可以实现让当前运行线程释放锁,还可以唤醒正处于waiting状态的线程

2.为什么需要wait/notify?他的使用场景是什么?

让获取了锁资源但缺乏其他资源不能有效运行的线程及时的释放掉锁资源,让其他线程能够及时的获取锁资源执行相应的任务,大大提高了线程的并发性

3.如何使用wait/notify/notifyAll?

需要搭配synchronized关键字使用,而且必须获取了锁资源之后才能使用(也就是必须在synchronized同步代码内使用)

那为什么必须获取到锁资源才能调用这几个方法呢?

A.首先wait方法本身就是针对获取了锁资源但缺乏其他资源不能及时有效运行从而导致锁资源没有得到及时释放的场景,所以调用wait方法必须先获取锁资源才能释放锁资源呀

B.notify/notifyAll,从wait()原理上来理解,一旦调用了wait方法及时释放了锁资源,线程的状态就会变成Wating状态(也属于阻塞状态的一种),进入到等待队列WaitSet中,而等待队列WaitSet属于锁资源的一部分,如果你不先获取到锁资源,那么你怎么能获取到等待队列WaitSet,进而唤醒队列中的线程呢

4.注意细节:

调用了wait()方法一定要调用相应的notify/notifyAll方法唤醒线程,否则线程将一直阻塞下去,程序也会因为有非守护线程没执行完而一直不能结束

一句话概括注意细节:

wait和notify/notifyAll一定要成对出现,有多少个wait就要有多少个notify/notifyAll

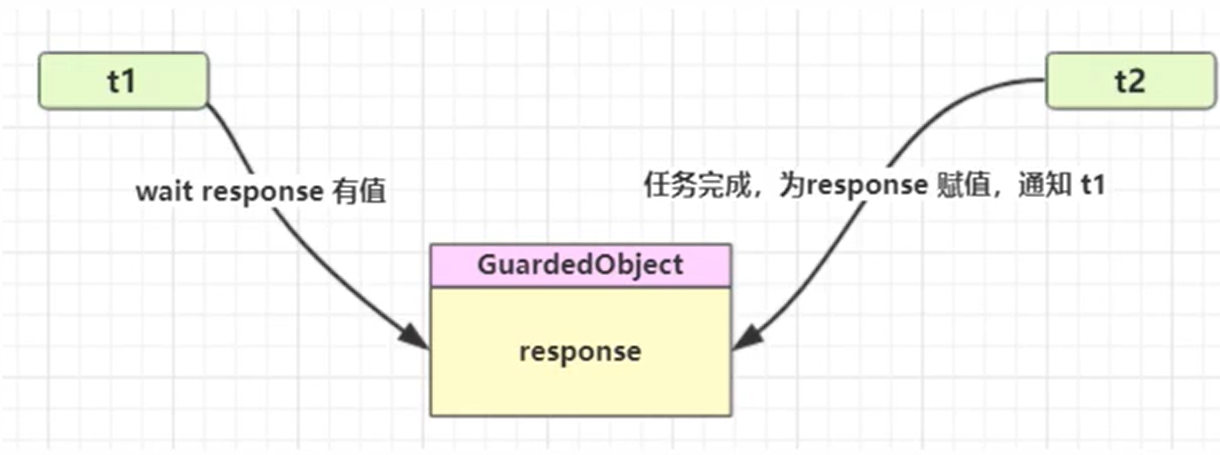

线程间的通信 保护性暂停模式通信 1.定义 即 Guarded Suspension,用在一个线程等待另一个线程的执行结果,实现线程之间相互传输结果(线程间的通信)

要点

有一个结果需要从一个线程传递到另一个线程,让他们关联同一个 GuardedObject(存储线程之间通信数据的存储空间)

如果有结果不断从一个线程到另一个线程那么可以使用消息队列(见生产者/消费者)

JDK 中,join 的实现、Future 的实现,采用的就是此模式

因为要等待另一方的结果,因此归类到同步模式

保护性暂停模式的特点:

1.线程与线程之间只能是一一对应关系 的

2.线程与线程之间的结果传输(通信)是同步的,为什么说是同步的呢?

因为生产者和消费者是一一对应关系的,生产者生产好消息后将消息设置在公共的数据存储空间中,消费者立马就可以获取

2.原理实现(无超时时间) 如果wait()没有设置超时时间,一定要调用notify/notifyAll方法手动唤醒正在等待的线程,否则等待的线程会一直阻塞下去

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 class GuardedObject { private Object response; private final Object lock = new Object (); public Object get () { synchronized (lock) { while (response == null ) { try { lock.wait(); } catch (InterruptedException e) { e.printStackTrace(); } } return response; } } public void complete (Object response) { synchronized (lock) { this .response = response; lock.notifyAll(); } } }

测试

一个线程等待另一个线程的执行结果

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 public static void main (String[] args) { GuardedObject guardedObject = new GuardedObject (); new Thread (()->{ log.info("生产数据开始..." ); try { Thread.sleep(2000 ); } catch (InterruptedException e) { e.printStackTrace(); } String data = new String ("data" ); log.info("生产数据完成..." ); guardedObject.complete(data); },"t1" ).start(); new Thread (()->{ log.info("获取数据开始..." ); String data = (String) guardedObject.get(); log.info("获取数据完成...数据是" +data); },"t2" ).start(); }

执行结果

1 2 3 4 11:12:29.444 [t2] INFO com.czq.GuardedObject - 获取数据开始... 11:12:29.444 [t1] INFO com.czq.GuardedObject - 生产数据开始... 11:12:31.455 [t1] INFO com.czq.GuardedObject - 生产数据完成... 11:12:31.455 [t2] INFO com.czq.GuardedObject - 获取数据完成...数据是data

原理实现(有超时时间) 如果要控制超时时间呢

控制超时的核心点:

1.如何实时计算剩余的等待时间,因为每次虚假唤醒都会消耗一定的时间

2.设置了超时时间为什么就不需要主动唤醒了?主动唤醒和不主动的唤醒的区别是什么?

因为线程在到达超时时间后就会自动唤醒。

区别:

如果正常设置了唤醒,那就是线程生产完数据后能立即通知另一个线程获取数据,如果没有设置唤醒,另一个线程则等待超时时间到达后再获取数据

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 class GuardedObjectV2 { public Object get (long timeOut) { synchronized (lock){ long begin = System.currentTimeMillis(); long parseTime=0 ; while (response==null ){ long waitTime = timeOut-parseTime; log.debug("waitTime: {}" , waitTime); if (waitTime<0 ){ break ; } try { lock.wait(waitTime); } catch (InterruptedException e) { e.printStackTrace(); } parseTime = System.currentTimeMillis()-begin; } return response; } } public void complete (Object object) { synchronized (lock){ this .response = object; } } }

测试,没有超时

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 public static void main (String[] args) { GuardedObject2 guardedObject = new GuardedObject2 (); new Thread (()->{ log.info("生产数据开始..." ); try { Thread.sleep(10 ); } catch (InterruptedException e) { e.printStackTrace(); } String data = new String ("data" ); log.info("生产数据完成..." ); guardedObject.complete(data); },"t1" ).start(); new Thread (()->{ log.info("获取数据开始..." ); String data = (String) guardedObject.get(20 ); log.info("获取数据完成...数据是" +data); },"t2" ).start(); }

输出

1 2 3 4 5 11:27:07.483 [t1] INFO com.czq.GuardedObject2 - 生产数据开始... 11:27:07.483 [t2] INFO com.czq.GuardedObject2 - 获取数据开始... 11:27:07.485 [t2] DEBUG com.czq.GuardedObject2 - waitTime: 20 11:27:07.501 [t1] INFO com.czq.GuardedObject2 - 生产数据完成... 11:27:07.517 [t2] INFO com.czq.GuardedObject2 - 获取数据完成...数据是data

测试超时

1 2 String data = (String) guardedObject.get(5 );

输出

1 2 3 4 5 6 11 :29 :29.730 [t1] INFO com.czq.GuardedObject2 - 生产数据开始...11 :29 :29.730 [t2] INFO com.czq.GuardedObject2 - 获取数据开始...11 :29 :29.732 [t2] DEBUG com.czq.GuardedObject2 - waitTime: 5 11 :29 :29.743 [t2] DEBUG com.czq.GuardedObject2 - waitTime: -6 11 :29 :29.743 [t1] INFO com.czq.GuardedObject2 - 生产数据完成...11 :29 :29.743 [t2] INFO com.czq.GuardedObject2 - 获取数据完成...数据是null

join方法的原理 是调用者轮询检查线程 alive 状态

等价于下面的代码,即join()方法的底层原理就是wait(long timeOut)

1 2 3 4 5 6 7 8 synchronized (t1) { while (t1.isAlive()) { t1.wait(0 ); } }

注意

join 体现的是【保护性暂停】模式,请参考源码解析

通过源码解析原理:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 public final void join () throws InterruptedException { join(0 ); } public final synchronized void join (long millis) throws InterruptedException { long base = System.currentTimeMillis(); long now = 0 ; if (millis < 0 ) { throw new IllegalArgumentException ("timeout value is negative" ); } if (millis == 0 ) { while (isAlive()) { wait(0 ); } } else { while (isAlive()) { long delay = millis - now; if (delay <= 0 ) { break ; } wait(delay); now = System.currentTimeMillis() - base; } } }

wait和join的区别 前提: wait方法和join方法都没有设置超时唤醒

1.因为join的底层就是wait,二者的原理基本一致,但有一处细微的区别,就是join方法会等待线程执行完才会自动唤醒,而wait方法只要拿到另一个线程的通信数据后就会自动唤醒,不需要等待线程执行完毕才唤醒

2.调用join()时不需要我们自己手动获取锁资源,手动调用wait/notify等方法,只要调用join()方法便有一条龙服务的功能,因为join()底层早已经帮我们封装好了(底层的实现是wait/notify..),而wait则需要我们手动获取了锁资源才能调用,所以调用起来join会比wait方便很多

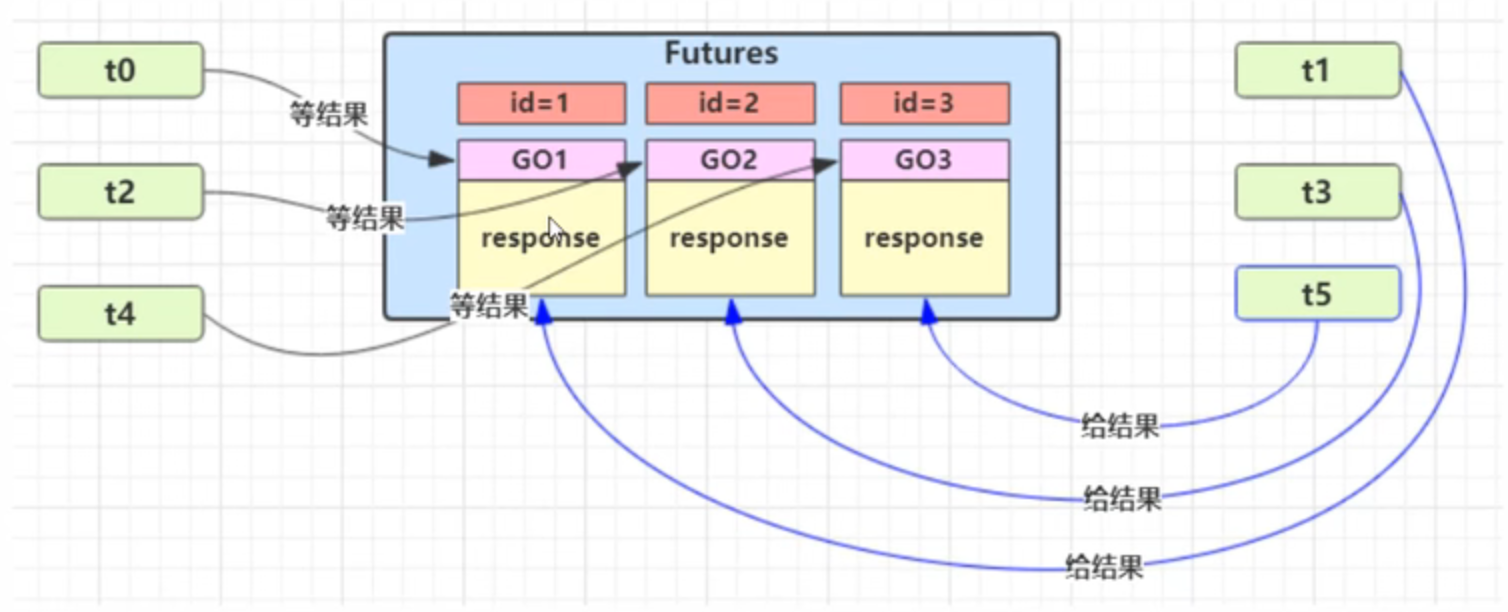

引入第三方中间类降低线程之间的耦合 通俗解读场景:

如果是存在多个一一对应的生产者和消费者,生产者和消费者都是动态变化的,耦合度非常强,可以通过引入一个第三方的中间类实现生产者和消费者的解耦并管理线程之间存储的通信数据

新增 id 用来标识 Guarded Object

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 @Slf4j public class GuardedObject3 { private final Object lock = new Object (); private Object data = null ; private int id; public void setId (int id) { this .id = id; } public int getId () { return id; } public void complete (Object data) { synchronized (lock){ this .data = data; lock.notifyAll(); } } public Object get (long timeOut) { synchronized (lock){ long begin = System.currentTimeMillis(); long parseTime=0 ; while (data == null ){ long waitTime = timeOut-parseTime; log.info("waitTime....{}" ,waitTime); if (waitTime<0 ){ break ; } try { lock.wait(waitTime); } catch (InterruptedException e) { e.printStackTrace(); } parseTime = System.currentTimeMillis() - begin; } return data; } } }

中间解耦类

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 class MailBox { private static final Map<Integer,GuardedObject3> guardedObjects = new Hashtable <>(); private static int id=1 ; private static synchronized int generatedId () { return id++; } public static GuardedObject3 createGuardedObject3 () { GuardedObject3 guardedObject3 = new GuardedObject3 (); int id = generatedId(); guardedObject3.setId(id); guardedObjects.put(id,guardedObject3); return guardedObject3; } public static GuardedObject3 getGuardedObject3 (Integer id) { return guardedObjects.remove(id); } public static Set<Integer> getIds () { return guardedObjects.keySet(); } }

业务相关类

1 2 3 4 5 6 7 8 9 10 class People extends Thread { @Override public void run () { GuardedObject guardedObject = Mailboxes.createGuardedObject(); log.debug("开始收信 id:{}" , guardedObject.getId()); Object mail = guardedObject.get(5000 ); log.debug("收到信 id:{}, 内容:{}" , guardedObject.getId(), mail); } }

1 2 3 4 5 6 7 8 9 10 11 12 13 14 class Postman extends Thread { private int id; private String mail; public Postman (int id, String mail) { this .id = id; this .mail = mail; } @Override public void run () { GuardedObject guardedObject = Mailboxes.getGuardedObject(id); log.debug("送信 id:{}, 内容:{}" , id, mail); guardedObject.complete(mail); } }

测试

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 public static void main (String[] args) { for (int i = 0 ; i < 3 ; i++) { new Peoples ().start(); } try { Thread.sleep(1000 ); } catch (InterruptedException e) { e.printStackTrace(); } for (Integer id : MailBox.getIds()) { new Postmans (id,"内容" +id).start(); } }

某次运行结果

1 2 3 4 5 6 7 8 9 10 11 12 16 :20 :49.086 [Thread-1 ] DEBUG com.czq.Peoples - 开始收信 id:2 16 :20 :49.086 [Thread-0 ] DEBUG com.czq.Peoples - 开始收信 id:1 16 :20 :49.086 [Thread-2 ] DEBUG com.czq.Peoples - 开始收信 id:3 16 :20 :49.090 [Thread-1 ] INFO com.czq.GuardedObject3 - waitTime....2000 16 :20 :49.090 [Thread-2 ] INFO com.czq.GuardedObject3 - waitTime....2000 16 :20 :49.090 [Thread-0 ] INFO com.czq.GuardedObject3 - waitTime....2000 16 :20 :50.092 [Thread-3 ] DEBUG com.czq.Postmans - 送信 id:3 , 内容:内容3 16 :20 :50.092 [Thread-4 ] DEBUG com.czq.Postmans - 送信 id:2 , 内容:内容2 16 :20 :50.092 [Thread-5 ] DEBUG com.czq.Postmans - 送信 id:1 , 内容:内容1 16 :20 :50.092 [Thread-0 ] DEBUG com.czq.Peoples - 收到信 id:1 , 内容:内容1 16 :20 :50.092 [Thread-1 ] DEBUG com.czq.Peoples - 收到信 id:2 , 内容:内容2 16 :20 :50.092 [Thread-2 ] DEBUG com.czq.Peoples - 收到信 id:3 , 内容:内容3

现在最大的困惑是引入第三方解耦线程之间的耦合的作用怎么理解?感觉没有前后对比感受不到他的好处

暂时的理解:

最大的作用是**将生产者线程和消费者线程的强耦合转化成了二者与第三方类的弱耦合(解除了生产者和消费者之间的强耦合)**,因为生产者和消费者是动态变化的,如果二者耦合,耦合度会非常强,而第三方类是静态的,基本不会发生变化,那就是弱耦合

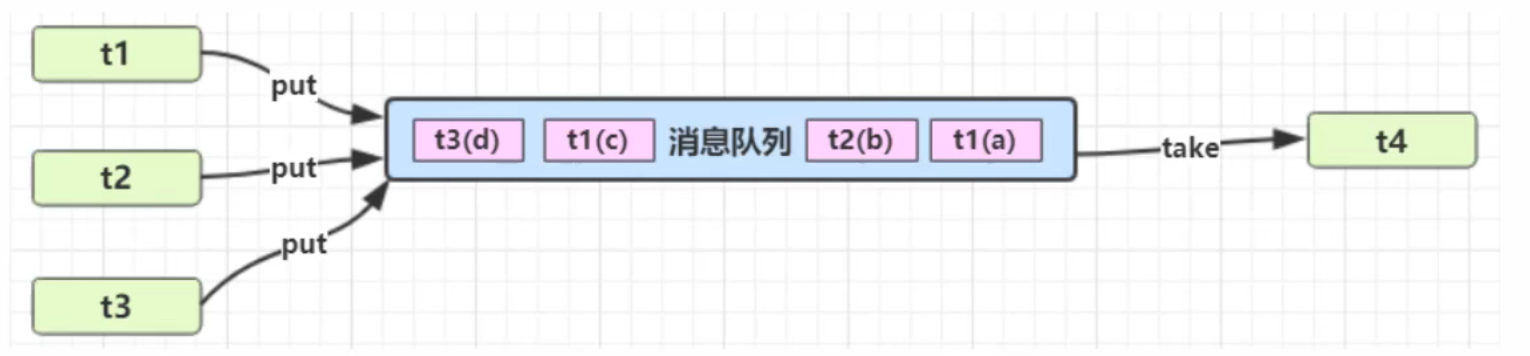

生产者消费者模式通信 1.定义 要点

与前面的保护性暂停模式中的 GuardObject 不同,不需要产生结果和消费结果的线程一一对应

消费队列可以用来平衡生产和消费的线程资源**(引入第三方中间类解耦的作用)**

生产者仅负责产生结果数据,不关心数据该如何处理,而消费者专心处理结果数据 (引入第三方中间类解耦的作用)

消息队列是有容量限制的,满时不会再加入数据,空时不会再消耗数据

JDK 中各种阻塞队列,采用的就是这种模式

保护性暂停模式和生产者消费者模式通信最大的区别是前者定义的线程只能一对一通信,后置可以实现一对多的通信

其次就是生产者消费者模式通信是异步的 ,因为生产者生产的消息需要在队列中排队等待 (一个生产者可以对应多个消费者,而队列中存储的可能是多个生产者生产的消息),消费不一定能立刻消费消息

2.实现 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 public class Message { private int id; private Object content; public Message (int id, String content) { this .id = id; this .content = content; } public int getId () { return id; } public Object getContent () { return content; } } package com.czq.two;import lombok.extern.slf4j.Slf4j;import java.util.LinkedList;@Slf4j public class MessageQueue { private final LinkedList<Message> queue; private int capacity; public MessageQueue (int capacity) { this .capacity = capacity; queue = new LinkedList <>(); } public void put (Message message) { synchronized (queue) { while (queue.size() == capacity){ try { log.debug("数据容器已满..." ); queue.wait(); } catch (InterruptedException e) { e.printStackTrace(); } } queue.push(message); queue.notifyAll(); } } public Message take () { synchronized (queue) { while (queue.isEmpty()){ try { log.debug("数据容器为空..." ); queue.wait(); } catch (InterruptedException e) { e.printStackTrace(); } } Message message = queue.poll(); queue.notifyAll(); return message; } } }

测试

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 @Slf4j public class Test { public static void main (String[] args) { MessageQueue messageQueue = new MessageQueue (2 ); for (int i = 0 ; i < 4 ; i++) { int id = i; new Thread (() -> { String response = "内容" +id; log.debug("try put message({})" , id); messageQueue.put(new Message (id, response)); }, "生产者" + i).start(); } try { Thread.sleep(3000 ); } catch (InterruptedException e) { e.printStackTrace(); } new Thread (() -> { while (true ) { Message message = messageQueue.take(); Object response = message.getContent(); log.debug("take message({}): [{}] lines" , message.getId(), response); } }, "消费者" ).start(); } }

某次运行结果

1 2 3 4 5 6 7 8 9 10 11 12 18:10:02.035 [生产者1] DEBUG com.czq.two.Test - try put message(1) 18:10:02.035 [生产者0] DEBUG com.czq.two.Test - try put message(0) 18:10:02.035 [生产者3] DEBUG com.czq.two.Test - try put message(3) 18:10:02.035 [生产者2] DEBUG com.czq.two.Test - try put message(2) 18:10:02.039 [生产者3] DEBUG com.czq.two.MessageQueue - 数据容器已满... 18:10:02.039 [生产者0] DEBUG com.czq.two.MessageQueue - 数据容器已满... 18:10:02.142 [生产者3] DEBUG com.czq.two.MessageQueue - 数据容器已满... 18:10:02.142 [消费者] DEBUG com.czq.two.Test - take message(2): [内容2] lines 18:10:02.142 [消费者] DEBUG com.czq.two.Test - take message(0): [内容0] lines 18:10:02.142 [消费者] DEBUG com.czq.two.Test - take message(3): [内容3] lines 18:10:02.142 [消费者] DEBUG com.czq.two.Test - take message(1): [内容1] lines 18:10:02.142 [消费者] DEBUG com.czq.two.MessageQueue - 数据容器为空...

线程间的通信总结 1.线程间的通信是什么?

这里的线程间的通信概念特指一个线程在等待另一个线程的执行结果 ,然后通过公共的存储空间实现结果的传输

2.为什么需要线程间的通信?

因为必然存在一个线程等待另一个线程的执行结果这样的业务场景 ,比如用户线程必须等待商家线程把交易金额算出来后才能付钱..

3.如何实现线程间的通信?

实现线程间通信的核心:

1.线程之间通过wait()和notify/notifyAll实现线程间的通信(通过wait方法实现线程之间的互相等待,通过notify/notifyAll放实现线程之间的互相唤醒)

2.线程之间使用一个公共的数据存储空间(GuardedObject和LinkedList等)存储线程之间的通信数据

疑问

为什么wait,notify/notifyAll是通信的核心之一?

因为wait,notify/notifyAll能够实现一个线程等待另一个线程的执行结果,待另一个线程产生执行结果后可以通过唤醒的方式通知原线程及时获取另一个线程的执行结果

Park & Unpark 基本使用 它们是 LockSupport 类中的方法

1 2 3 4 LockSupport.park(); LockSupport.unpark(暂停线程对象)

先 park 再 unpark

1 2 3 4 5 6 7 8 9 10 11 Thread t1 = new Thread (() -> { log.debug("start..." ); sleep(1 ); log.debug("park..." ); LockSupport.park(); log.debug("resume..." ); },"t1" ); t1.start(); sleep(2 ); log.debug("unpark..." ); LockSupport.unpark(t1);

输出

1 2 3 4 22:06:39.463 [t1] DEBUG com.czq.two.Test2 - start... 22:06:39.468 [t1] DEBUG com.czq.two.Test2 - park... 22:06:39.468 [main] DEBUG com.czq.two.Test2 - unpark... 22:06:39.468 [t1] DEBUG com.czq.two.Test2 - resume...

先 unpark 再 park

1 2 3 4 5 6 7 8 9 10 11 Thread t1 = new Thread (() -> { log.debug("start..." ); sleep(2 ); log.debug("park..." ); LockSupport.park(); log.debug("resume..." ); }, "t1" ); t1.start(); sleep(1 ); log.debug("unpark..." ); LockSupport.unpark(t1);

输出

1 2 3 4 22:07:08.845 [main] DEBUG com.czq.two.Test2 - unpark... 22:07:08.845 [t1] DEBUG com.czq.two.Test2 - start... 22:07:08.855 [t1] DEBUG com.czq.two.Test2 - park... 22:07:08.855 [t1] DEBUG com.czq.two.Test2 - resume...

特点 与 Object 的 wait & notify 相比

wait,notify 和 notifyAll 必须配合 Object Monitor 一起使用,而 park,unpark 不必

park & unpark 是以线程为单位来【阻塞】和【唤醒】线程,而 notify 只能随机唤醒一个等待线程,notifyAll 是唤醒所有等待线程,就不那么【精确】

park & unpark 可以先 unpark,而 wait & notify 不能先 notify

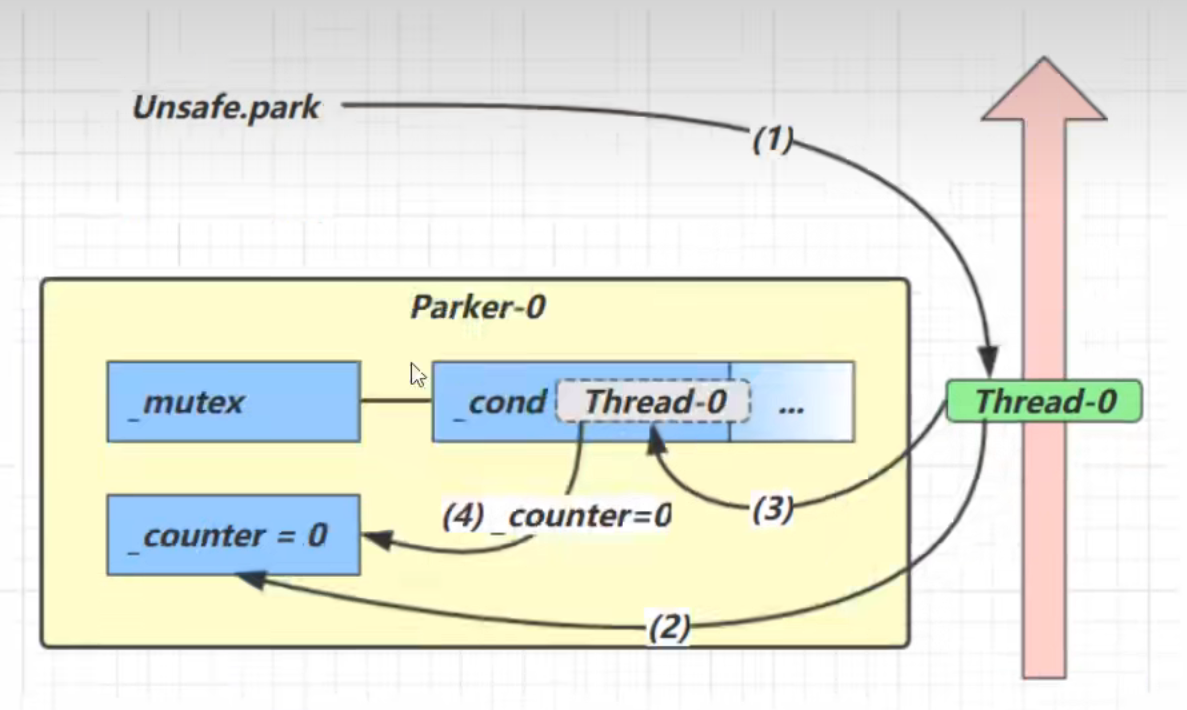

park和unpark的原理 每个线程都有自己的一个 Parker 对象(由C++编写,java中不可见),由三部分组成 _counter , _cond 和 _mutex 打个比喻

park方法原理

counter值为0的情况:

1.如果counter变量的值为0

2.则获取互斥锁让当前线程切换到阻塞状态并让当前线程进入到cond阻塞队列中等待

3.并再次设置counter值为0

counter值为1的情况:

1.如果counter变量的值为1

2.让线程继续正常执行下去并设置counter值为0

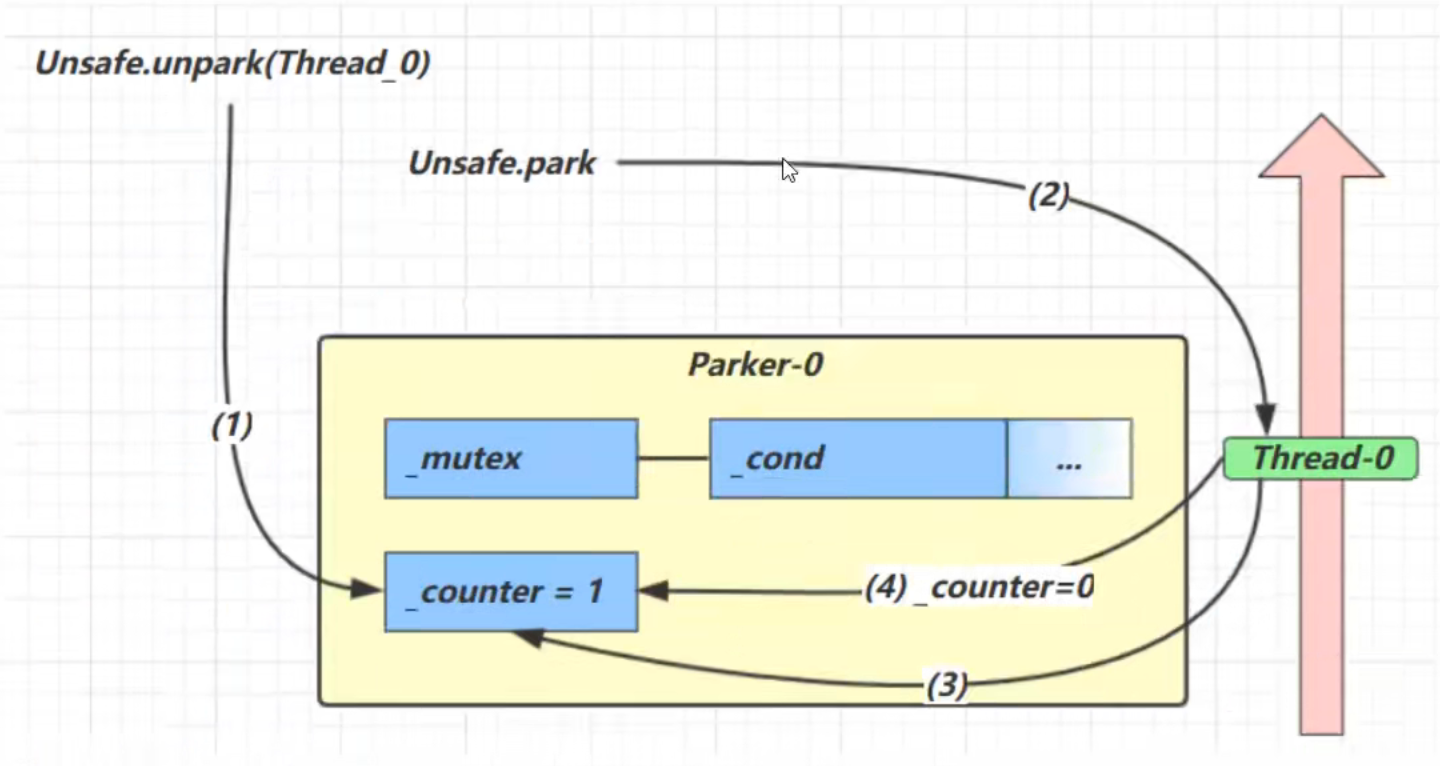

unpark方法原理

1.将counter变量的值从0置为1

2.唤醒cond阻塞队列中的线程让其继续执行

3.如果counter值本来就是1,那将会重复设置counter变量的值为1并且不需要唤醒阻塞队列中的线程

总结 1.Park &Unpark是什么?

是实现线程阻塞状态和运行状态互相转换的一种方式

2.为什么需要Park & Unpark?他的使用场景是什么?

Park & Unpark可以解决在线程成功获取到锁的资源后但缺乏其他资源而导致的线程不能得到有效运行和不能及时释放锁的问题(和wait/notify的使用场景类似)

3.怎么使用Park & Unpark?使用原理是什么?

park和unpark的原理与操作的PV操作原理非常像,park操作做信号量的减法(从1->0),如果已经是0则让线程阻塞。unpark操作做信号量的加法(从0->1),如果已经是1则不需要唤醒阻塞队列中的线程

4.park &unpark对比synchronized重量级锁和ReentrantLock重量级锁的等待唤醒机制有什么优势吗?

A.park & unpark支持唤醒指定的某个线程,这是synchronized重量级锁和ReentrantLock重量级锁实现不了的

B.park & unpark使用起来非常简单和灵活(因为他的原理是基于操作系统的PV操作),不像synchronized重量级锁实现起来非常的复杂 ,需要保证wait和notify成对出现,还要使用循环避免虚假唤醒和只有一次判断资源的情况,还需要保证加了锁必须要手动释放锁

即使是ReentrantLock重量级锁实现起来也和synchronized重量级锁类似,同样复杂 ,只是ReentrantLock重量级锁对synchronized锁做了些许优化罢了

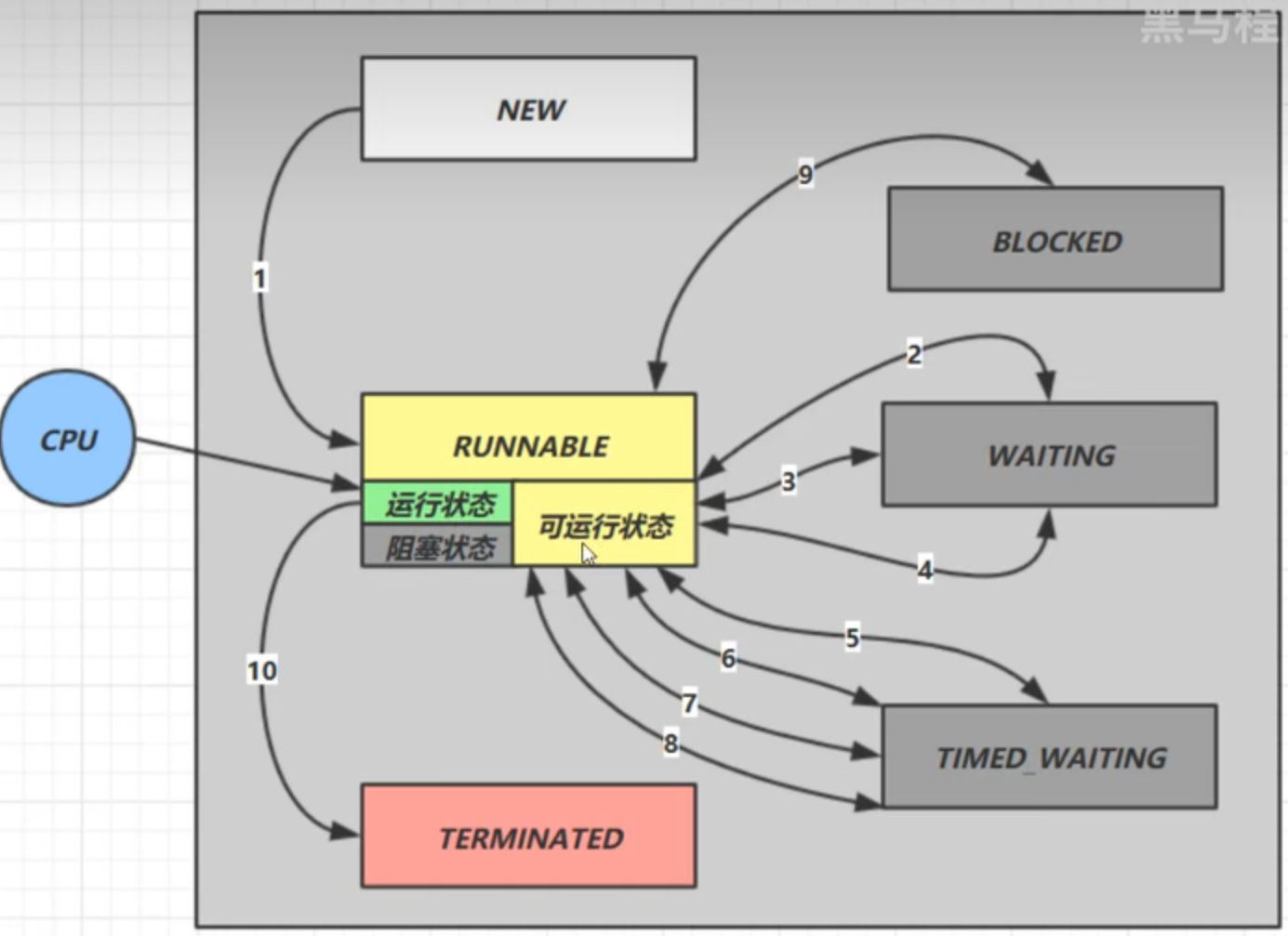

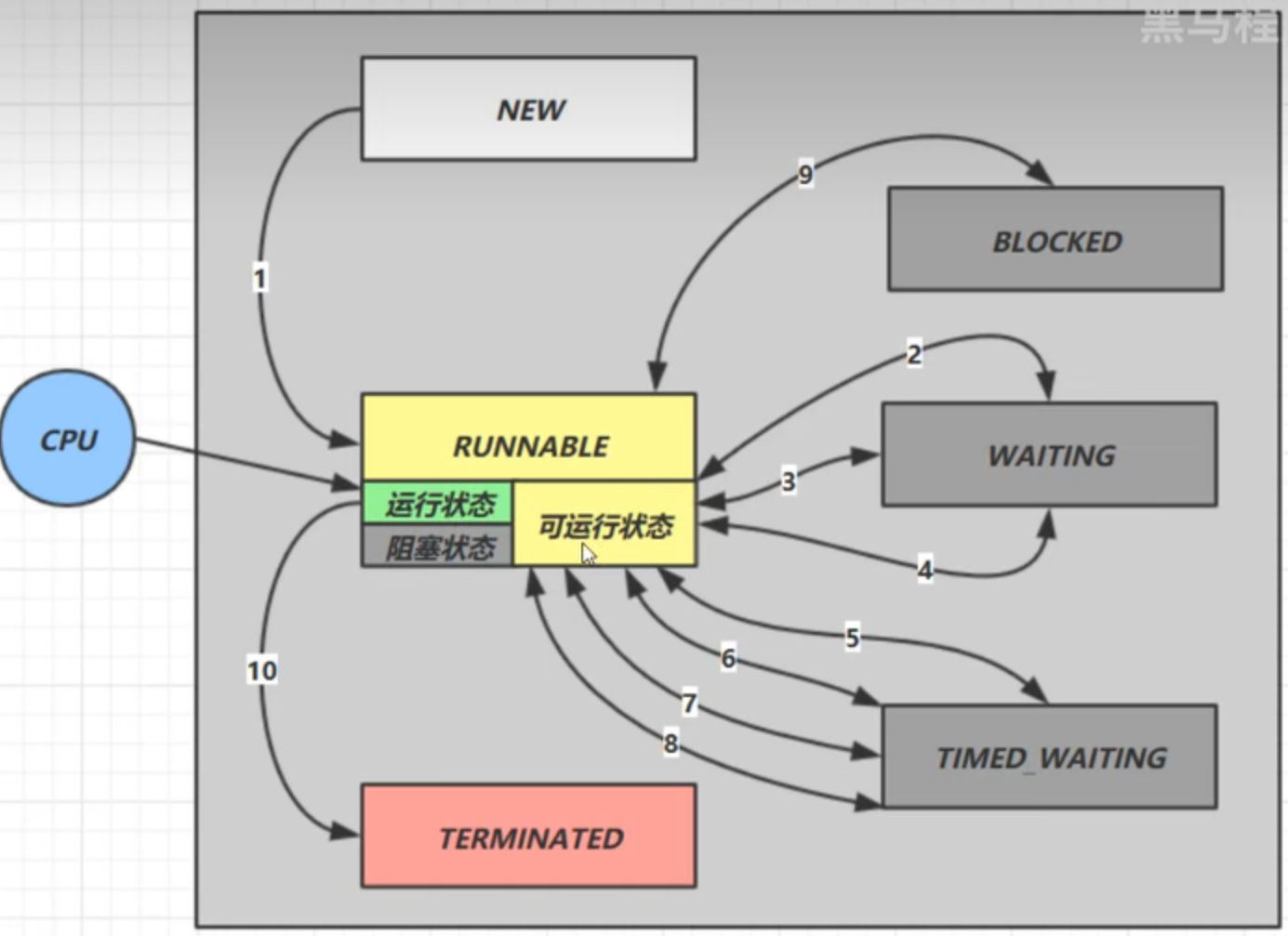

重新理解线程状态转换

BLOCKED,WAITING,TIME_WAITING是三种不同的阻塞状态,虽然都是阻塞状态,但他们的类型不一样

假设有线程 Thread t

情况 1 NEW --> RUNNABLE

当调用 t.start() 方法时,由 NEW –> RUNNABLE

NEW状态代表只是在Java层面新建一个线程对象,但该线程对象还没有与操作系统的线程关联起来,还不是真正意义上的线程

NEW->RUNNABLE代表Java层面的线程对象成功与操作系统的线程关联起来了并且启动线程的运行

情况 2 RUNNABLE <--> WAITING/TIMED_WAITING t 线程 用 synchronized(obj) 获取了对象锁后

调用 obj.wait() 方法时,t 线程 从 RUNNABLE --> WAITING

调用 obj.notify() , obj.notifyAll() , t.interrupt() 时

阶段一:线程被notify之后不会直接参与竞争锁,因为唤醒他们的线程正在使用锁,根本就没有竞争锁的机会,所以线程被notify之后是直接从waitset等待队列进入entrylist阻塞队列,对应的状态就是从WAITING变为BLOCKED

阶段二:等待占有锁的线程释放锁后,阻塞队列entrylist中的线程就会竞争锁,如果竞争成功,线程的状态就会从WATING切换到RUNNABLE,如果失败则继续阻塞等待下一次的锁的竞争

如果obj.wait(long timeOut)带超时时间,超时之后同样是从waitset等待队列进入entrylist阻塞队列中,原理和没有超时基本是一致的,只是多个超时时间控制

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 public class TestWaitNotify { final static Object obj = new Object (); public static void main (String[] args) { new Thread (() -> { synchronized (obj) { log.debug("执行...." ); try { obj.wait(); } catch (InterruptedException e) { e.printStackTrace(); } log.debug("其它代码...." ); } },"t1" ).start(); new Thread (() -> { synchronized (obj) { log.debug("执行...." ); try { obj.wait(); } catch (InterruptedException e) { e.printStackTrace(); } log.debug("其它代码...." ); } },"t2" ).start(); sleep(0.5 ); log.debug("唤醒 obj 上其它线程" ); synchronized (obj) { obj.notifyAll(); } } }

情况 3 RUNNABLE <--> WAITING/TIMED_WAITING

当前线程 调用 t.join() 方法时,当前线程 从 RUNNABLE --> WAITING 注意是当前线程 在t 线程对象 的监视器上等待 如果t 线程 运行结束,或者调用了当前线程 的 interrupt() 时,当前线程从 WAITING --> RUNNABLEjoin方法底层就是wait,无论是有无超时时间,他们的状态转换原理和wait基本是一致的

细节:区分好t.wait()方法和t.join()方法阻塞的线程对象是谁,虽然二者都是阻塞当前正在运行的线程,但其实二者正在运行的线程对象是不一样的

比如t.wait()方法代表t线程就是当前正在运行的线程,而t.join()方法中t线程并不是当前正在运行的线程

情况 4 RUNNABLE <--> TIMED_WAITING

当前线程 调用 Thread.sleep(long n) ,当前线程 从 RUNNABLE --> TIMED_WAITING 当前线程 等待时间超过了 n 毫秒,当前线程 从 TIMED_WAITING --> RUNNABLE

在线程状态转换原理上和wait方法的区别:

wait(long n)会先进入到waitset等待队列中,直到锁释放才会进入到entrylist阻塞队列中竞争锁,而sleep方法是直接进入到entrylist阻塞队列中,不需要进入到waitset等待队列中

情况 5 RUNNABLE <--> TIMED_WAITING

当前线程 调用 LockSupport.parkNanos(long nanos) 或 LockSupport.parkUntil(long millis) 时,当前线程 从 RUNNABLE --> TIMED_WAITING 调用 LockSupport.unpark(目标线程) 或调用了线程 的 interrupt() ,或是等待超时,会让目标线程从 TIMED_WAITING--> RUNNABLE

情况 6 RUNNABLE <--> BLOCKED

t 线程 用 synchronized(obj) 获取了对象锁时如果竞争失败,从 RUNNABLE --> BLOCKED 持 obj 锁线程的同步代码块执行完毕,会唤醒该对象上所有 BLOCKED 的线程重新竞争,如果其中 t 线程 竞争 成功,从 BLOCKED --> RUNNABLE ,其它失败的线程仍然 BLOCKED

情况 7 RUNNABLE <--> TERMINATED

当前线程所有代码运行完毕,进入 TERMINATED

总结 线程状态的转换实际上把前面所有知识都串联起来了,这里面涉及重量级锁Monitor的原理,start(),wait(),join(),notify()/notifyAll(),park(),unpark()等方法的原理知识

1.调用线程的start()方法可以让线程从NEW->RUNNABLE

2.调用线程的sleep(),wait(),join(),park()方法让线程从RUNNABLE->WAITING/TIME_WAITING

3.调用线程的interrupt(),notify()/notifyAll(),unpark()让线程从WAITING/TIMED_WAITING->RUNNABLE

4.竞争重量级锁Mointor成功和失败则可以让线程在RUNNABE<–>BLOCKED两个状态之间切换

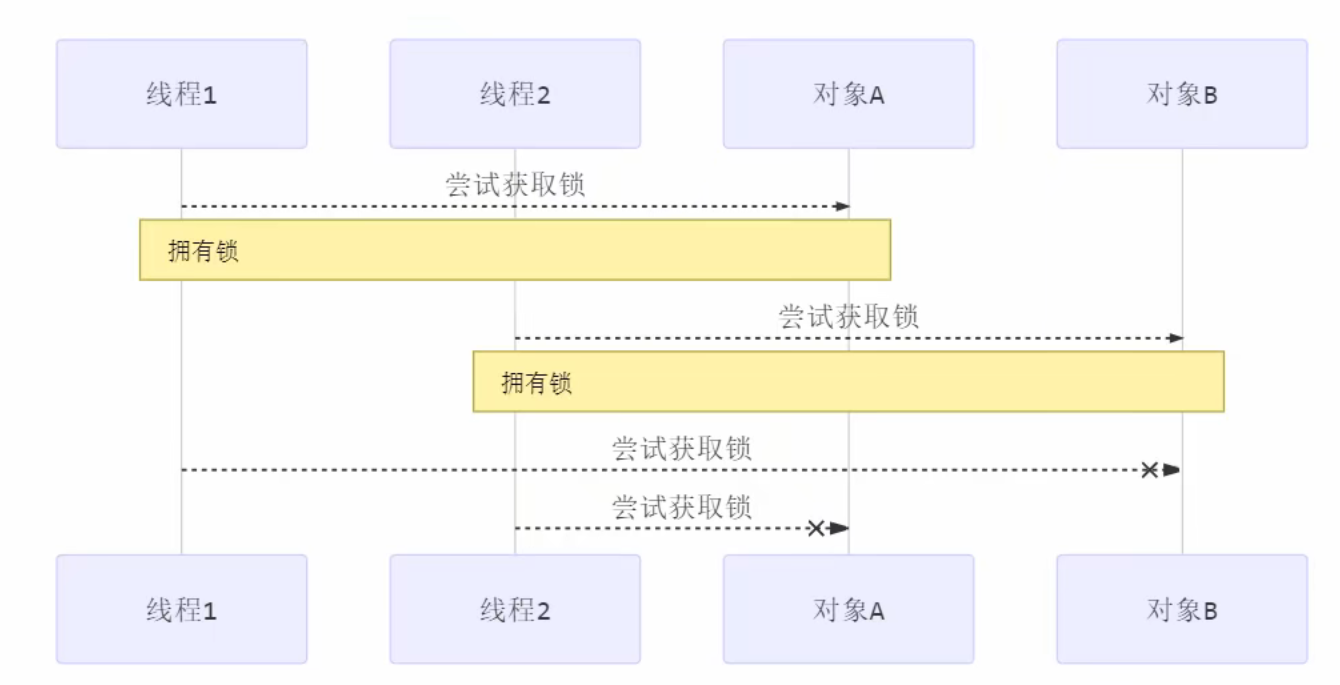

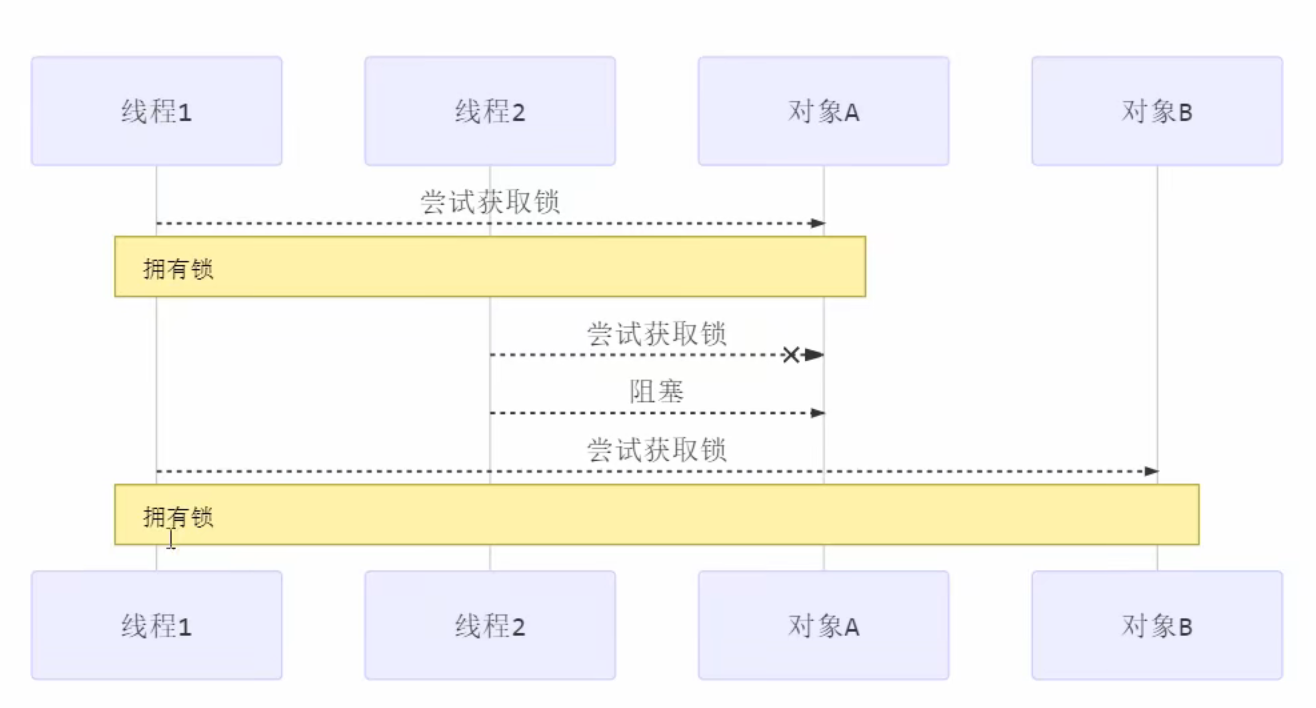

线程的活跃性 死锁 有这样的情况:一个线程需要同时获取多把锁,这时就容易发生死锁

核心理解:线程之间彼此都想获取对方手上的资源但又不想释放自己手上的资源,就会发生死锁现象

t1 线程 获得 A对象 锁,接下来想获取 B对象 的锁 t2 线程 获得 B对象 锁,接下来想获取 A对象 的锁 例:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 Object A = new Object ();Object B = new Object ();Thread t1 = new Thread (() -> { synchronized (A) { log.debug("lock A" ); sleep(1 ); synchronized (B) { log.debug("lock B" ); log.debug("操作..." ); } } }, "t1" ); Thread t2 = new Thread (() -> { synchronized (B) { log.debug("lock B" ); sleep(0.5 ); synchronized (A) { log.debug("lock A" ); log.debug("操作..." ); } } }, "t2" ); t1.start(); t2.start();

结果

1 2 12:22:06.962 [t2] c.TestDeadLock - lock B 12:22:06.962 [t1] c.TestDeadLock - lock A

解决方式:

定位死锁 检测死锁可以使用 jconsole工具,或者使用 jps 定位进程 id,再用 jstack 定位死锁:

1 2 3 4 5 6 7 cmd > jps Picked up JAVA_TOOL_OPTIONS: -Dfile.encoding=UTF-8 12320 Jps 22816 KotlinCompileDaemon 33200 TestDeadLock // JVM 进程 11508 Main 28468 Launcher

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 cmd > jstack 33200 Picked up JAVA_TOOL_OPTIONS: -Dfile.encoding=UTF-8 2018-12-29 05:51:40 Full thread dump Java HotSpot(TM) 64-Bit Server VM (25.91-b14 mixed mode): "DestroyJavaVM" [0x0000000000000000] java.lang.Thread.State: RUNNABLE "Thread-1" [0x000000001f54f000] java.lang.Thread.State: BLOCKED (on object monitor) at thread.TestDeadLock.lambda$main$1 (TestDeadLock.java:28) - waiting to lock <0x000000076b5bf1c0> (a java.lang.Object) - locked <0x000000076b5bf1d0> (a java.lang.Object) at thread.TestDeadLock$$Lambda$2 /883049899.run(Unknown Source) at java.lang.Thread.run(Thread.java:745) "Thread-0" [0x000000001f44f000] java.lang.Thread.State: BLOCKED (on object monitor) at thread.TestDeadLock.lambda$main$0 (TestDeadLock.java:15) - waiting to lock <0x000000076b5bf1d0> (a java.lang.Object) - locked <0x000000076b5bf1c0> (a java.lang.Object) at thread.TestDeadLock$$Lambda$1 /495053715.run(Unknown Source) at java.lang.Thread.run(Thread.java:745) // 略去部分输出 Found one Java-level deadlock: ============================= "Thread-1" : waiting to lock monitor 0x000000000361d378 (object 0x000000076b5bf1c0, a java.lang.Object), which is held by "Thread-0" "Thread-0" : waiting to lock monitor 0x000000000361e768 (object 0x000000076b5bf1d0, a java.lang.Object), which is held by "Thread-1" Java stack information for the threads listed above: =================================================== "Thread-1" : at thread.TestDeadLock.lambda$main$1 (TestDeadLock.java:28) - waiting to lock <0x000000076b5bf1c0> (a java.lang.Object) - locked <0x000000076b5bf1d0> (a java.lang.Object) at thread.TestDeadLock$$Lambda$2 /883049899.run(Unknown Source) at java.lang.Thread.run(Thread.java:745) "Thread-0" : at thread.TestDeadLock.lambda$main$0 (TestDeadLock.java:15) - waiting to lock <0x000000076b5bf1d0> (a java.lang.Object) - locked <0x000000076b5bf1c0> (a java.lang.Object) at thread.TestDeadLock$$Lambda$1 /495053715.run(Unknown Source) at java.lang.Thread.run(Thread.java:745) Found 1 deadlock.

避免死锁要注意加锁顺序

另外如果由于某个线程进入了死循环,导致其它线程一直等待,对于这种情况 linux 下可以通过 top 先定位到 CPU 占用高的 Java 进程,再利用 top -Hp 进程id 来定位是哪个线程,最后再用 jstack 排查

活锁 核心理解:线程彼此都在改变对方线程结束的运行条件(让其不能结束运行),那就会出现活锁现象

通俗点来说:两个线程都在扰乱对方的正常运行,比如一个人在给泳池加水,另一个人却一直在泳池放水,那这不就导致泳池永远都加不满水,也放不尽水,两人隔着无休止的捣乱

活锁出现在两个线程互相改变对方的结束条件,最后谁也无法结束,例如

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 public class TestLiveLock { static volatile int count = 10 ; static final Object lock = new Object (); public static void main (String[] args) { new Thread (() -> { while (count > 0 ) { sleep(0.2 ); count--; log.debug("count: {}" , count); } }, "t1" ).start(); new Thread (() -> { while (count < 20 ) { sleep(0.2 ); count++; log.debug("count: {}" , count); } }, "t2" ).start(); } }

解决方式:

错开线程的运行时间,使得一方不能改变另一方的结束条件。

将睡眠时间调整为随机数。

饥饿 很多教程中把饥饿定义为,一个线程由于优先级太低,始终得不到 CPU 调度执行,也不能够结束,饥饿的情况不易演示,讲读写锁时会涉及饥饿问题

下面我讲一下我遇到的一个线程饥饿的例子,先来看看使用顺序加锁的方式解决之前的死锁问题

顺序加锁的解决方案

说明:

顺序加锁可以解决死锁问题,但也会导致一些线程一直得不到锁,产生饥饿现象。

解决方式:ReentrantLock

总结 1.线程的活跃性是什么?

线程的活跃性是指线程一直处于运行状态而不能有效停止,导致线程活跃性的原因有死锁,活锁

2.为什么需要线程的活跃性?

深入理解死锁,活锁,可以预防出现此类问题而导致线程处于一直运行状态而不能得到有效的停止

3.如何使用线程的活跃性?

我们是预防死锁,活锁的出现,当然,如果你想要重现这些场景,你可以根据死锁,活锁的原理进行复现

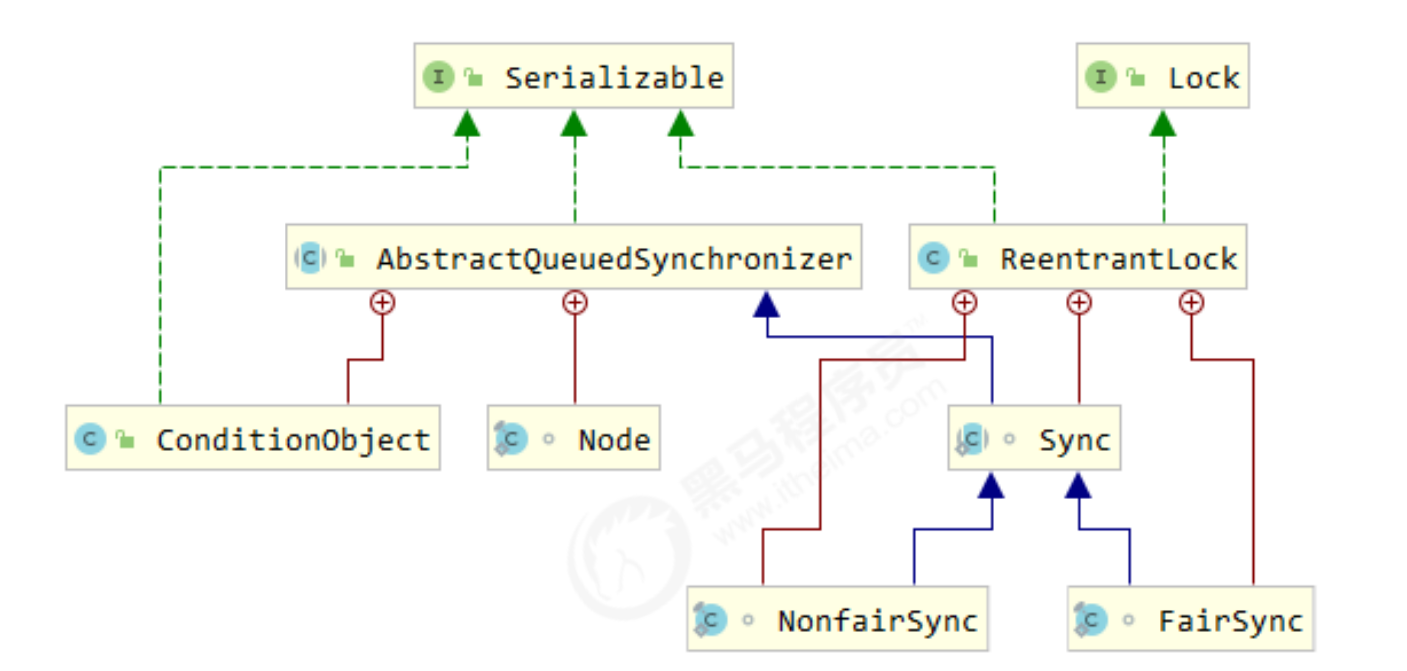

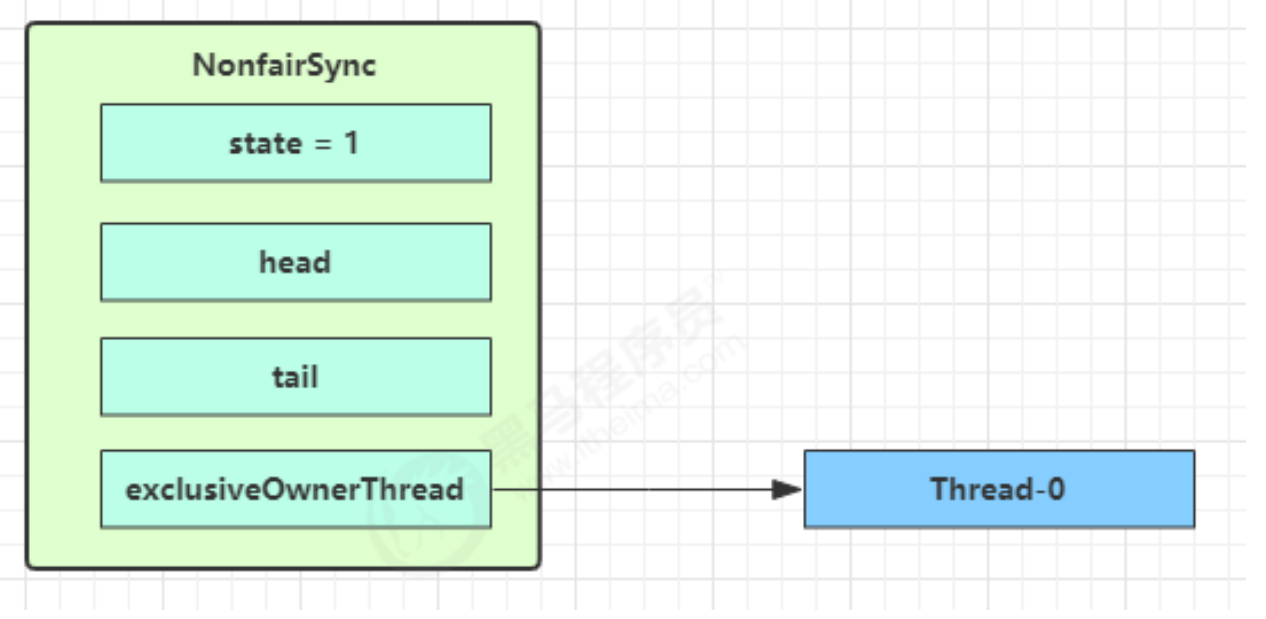

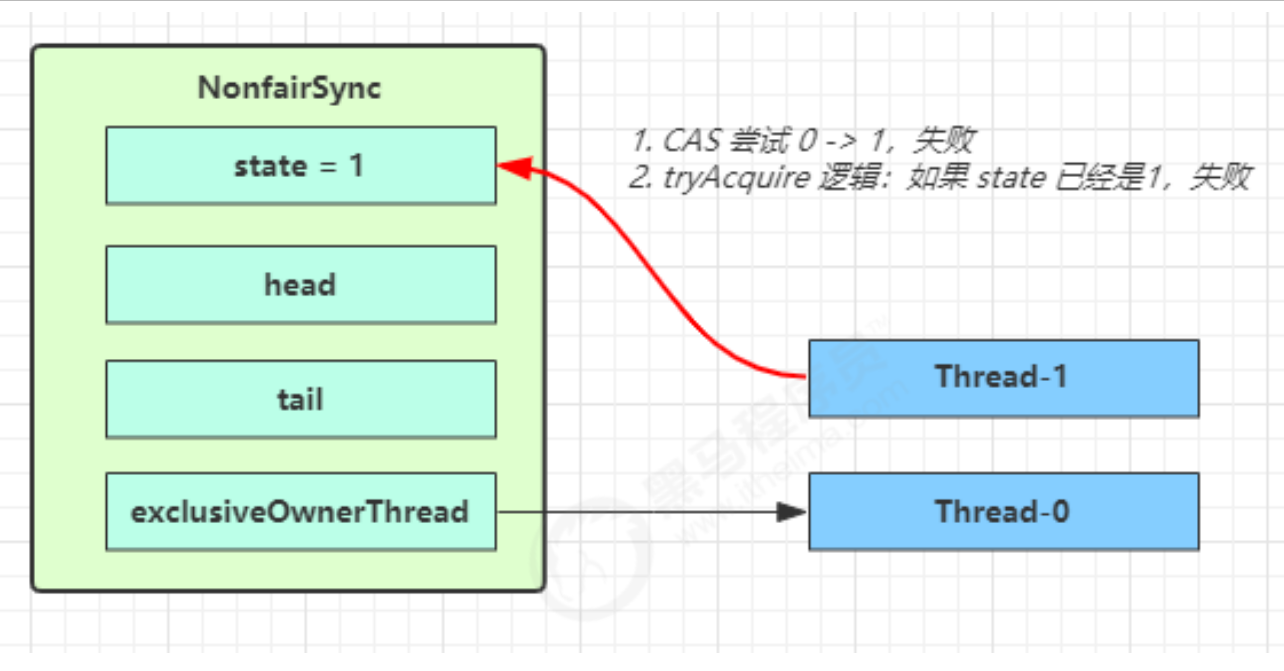

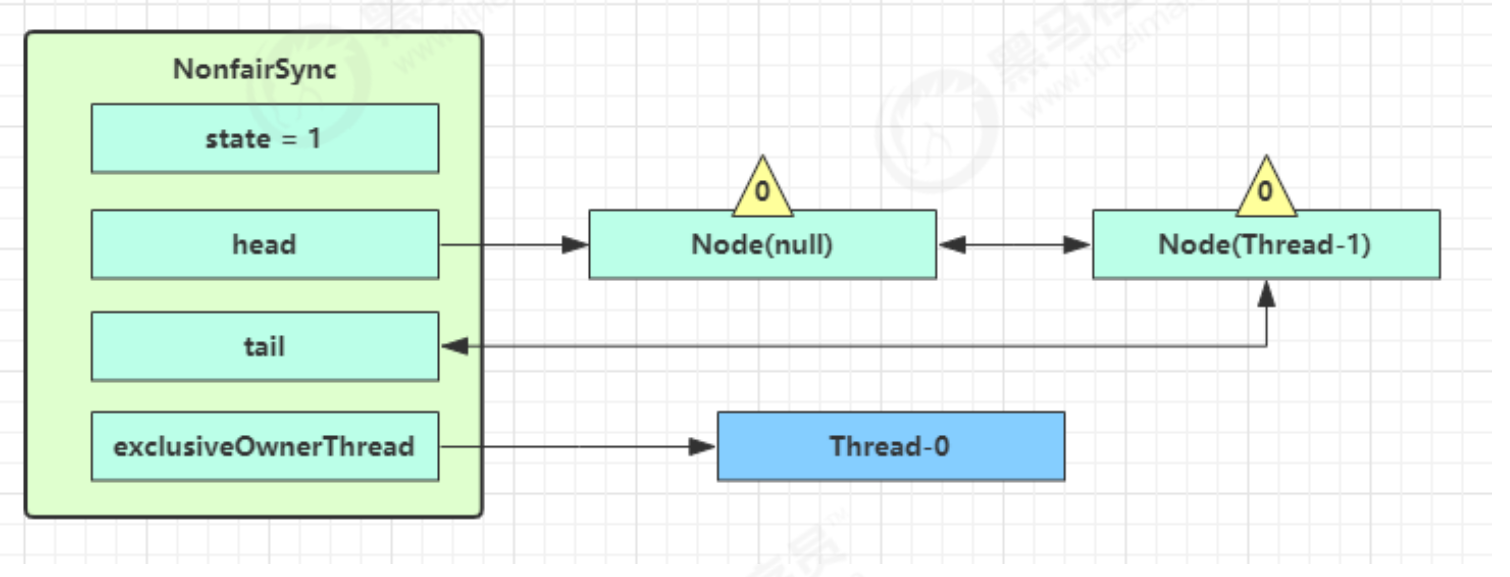

ReentrantLock 相对于 synchronized 它具备如下特点

可中断 可以设置超时时间 可以设置为公平锁

支持多个条件变量

与 synchronized 一样,都支持可重入

基本语法

1 2 3 4 5 6 7 8 reentrantLock.lock(); try { } finally { reentrantLock.unlock(); }

可重入 可重入是指同一个线程如果首次获得了这把锁,那么因为它是这把锁的拥有者,因此有权利再次获取这把锁 如果是不可重入锁,那么第二次获得锁时,自己也会被锁挡住。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 static ReentrantLock lock = new ReentrantLock ();public static void main (String[] args) { method1(); } public static void method1 () { lock.lock(); try { log.debug("execute method1" ); method2(); } finally { lock.unlock(); } } public static void method2 () { lock.lock(); try { log.debug("execute method2" ); method3(); } finally { lock.unlock(); } } public static void method3 () { lock.lock(); try { log.debug("execute method3" ); } finally { lock.unlock(); } }

输出

1 2 3 17:59:11.862 [main] c.TestReentrant - execute method1 17:59:11.865 [main] c.TestReentrant - execute method2 17:59:11.865 [main] c.TestReentrant - execute method3

可打断 可打断指的是处于阻塞状态等待锁的线程可以被打断等待。注意lock.lockInterruptibly()和lock.trylock()方法是可打断的,lock.lock()不是。可打断的意义在于避免得不到锁的线程无限制地等待下去,防止死锁的一种方式

核心理解:可以打断因竞争锁失败而导致的线程阻塞状态,避免获取不到锁的线程无休止的阻塞等待下去。这恰恰是优化了synchronized因为获取锁失败而无休止的阻塞等待的缺陷

缺陷:

因为打断这种方式是由其他正在运行状态的线程对阻塞状态的线程进行打断,对于阻塞状态的线程而言是被动打断,仍然不能主动结束自己的打断状态,仍有一定的缺陷

示例

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 ReentrantLock lock = new ReentrantLock ();Thread t1 = new Thread (() -> { log.debug("启动..." ); try { lock.lockInterruptibly(); } catch (InterruptedException e) { e.printStackTrace(); log.debug("等锁的过程中被打断" ); return ; } try { log.debug("获得了锁" ); } finally { lock.unlock(); } }, "t1" ); lock.lock(); log.debug("获得了锁" ); t1.start(); try { sleep(1 ); t1.interrupt(); log.debug("执行打断" ); } finally { lock.unlock(); }

输出

1 2 3 4 5 6 7 8 9 10 11 12 13 14 18:02:40.520 [main] c.TestInterrupt - 获得了锁 18:02:40.524 [t1] c.TestInterrupt - 启动... 18:02:41.530 [main] c.TestInterrupt - 执行打断 java.lang.InterruptedException at java.util.concurrent.locks.AbstractQueuedSynchronizer.doAcquireInterruptibly(AbstractQueuedSynchr onizer.java:898) at java.util.concurrent.locks.AbstractQueuedSynchronizer.acquireInterruptibly(AbstractQueuedSynchron izer.java:1222) at java.util.concurrent.locks.ReentrantLock.lockInterruptibly(ReentrantLock.java:335) at cn.itcast.n4.reentrant.TestInterrupt.lambda$main$0 (TestInterrupt.java:17) at java.lang.Thread.run(Thread.java:748) 18:02:41.532 [t1] c.TestInterrupt - 等锁的过程中被打断

当然ReentrantLock也支持不可打断,调用的是lock.lock()方法api

注意如果是不可中断模式,那么即使使用了 interrupt 也不会让等待中断

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 ReentrantLock lock = new ReentrantLock ();Thread t1 = new Thread (() -> { log.debug("启动..." ); lock.lock(); try { log.debug("获得了锁" ); } finally { lock.unlock(); } }, "t1" ); lock.lock(); log.debug("获得了锁" ); t1.start(); try { sleep(1 ); t1.interrupt(); log.debug("执行打断" ); sleep(1 ); } finally { log.debug("释放了锁" ); lock.unlock(); }

输出

1 2 3 4 5 18:06:56.261 [main] c.TestInterrupt - 获得了锁 18:06:56.265 [t1] c.TestInterrupt - 启动... 18:06:57.266 [main] c.TestInterrupt - 执行打断 // 这时 t1 并没有被真正打断, 而是仍继续等待锁 18:06:58.267 [main] c.TestInterrupt - 释放了锁 18:06:58.267 [t1] c.TestInterrupt - 获得了锁

锁超时 核心理解:可以主动结束因为线程竞争锁失败而导致的阻塞状态,这是对打断(被动结束)方式的一种优化

有两种实现方式:

1.立即失败,只要线程竞争锁失败,线程不会进入阻塞状态等待锁的释放,而是会正常执行下去

2.超时失败:线程在设定时间内,多次重复竞争锁资源,在超出设定时间后,线程不会在等待,而是会正常执行下去

立刻失败

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 ReentrantLock lock = new ReentrantLock ();Thread t1 = new Thread (() -> { log.debug("启动..." ); if (!lock.tryLock()) { log.debug("获取立刻失败,返回" ); return ; } try { log.debug("获得了锁" ); } finally { lock.unlock(); } }, "t1" ); lock.lock(); log.debug("获得了锁" ); t1.start(); try { sleep(2 ); } finally { lock.unlock(); }

输出

1 2 3 18:15:02.918 [main] c.TestTimeout - 获得了锁 18:15:02.921 [t1] c.TestTimeout - 启动... 18:15:02.921 [t1] c.TestTimeout - 获取立刻失败,返回

超时失败

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 ReentrantLock lock = new ReentrantLock ();Thread t1 = new Thread (() -> { log.debug("启动..." ); try { if (!lock.tryLock(1 , TimeUnit.SECONDS)) { log.debug("获取等待 1s 后失败,返回" ); return ; } } catch (InterruptedException e) { e.printStackTrace(); } try { log.debug("获得了锁" ); } finally { lock.unlock(); } }, "t1" ); lock.lock(); log.debug("获得了锁" ); t1.start(); try { sleep(2 ); } finally { lock.unlock(); }

输出

1 2 3 18:19:40.537 [main] c.TestTimeout - 获得了锁 18:19:40.544 [t1] c.TestTimeout - 启动... 18:19:41.547 [t1] c.TestTimeout - 获取等待 1s 后失败,返回

使用 tryLock 解决哲学家就餐问题

1 2 3 4 5 6 7 8 9 10 class Chopstick extends ReentrantLock { String name; public Chopstick (String name) { this .name = name; } @Override public String toString () { return "筷子{" + name + '}' ; } }

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 class Philosopher extends Thread { Chopstick left; Chopstick right; public Philosopher (String name, Chopstick left, Chopstick right) { super (name); this .left = left; this .right = right; } @Override public void run () { while (true ) { if (left.tryLock()) { try { if (right.tryLock()) { try { eat(); } finally { right.unlock(); } } } finally { left.unlock(); } } } } private void eat () { log.debug("eating..." ); Sleeper.sleep(1 ); } }

公平锁 ReentrantLock 默认是不公平的